Suite à des échanges avec Alexandre au sujet de la “position” et de l’usage de Ollama dans le domaine des LLM, j’ai pris un peu de temps pour essayer d’y voir plus clair.

JaiLu ce thread Reddit : newbie confusion: LocalLM / AnythingLLM / llama.cpp / Lamafile / Ollama / openwebui All the same? : LocalLLM

Voici ma description d’Ollama. Ollama est un wrapper au-dessus de Llama.cpp afin de rendre son utilisation davantage User Friendly. Ollama est écrit en Golang.

D’après :

Supported backends

- llama.cpp project founded by Georgi Gerganov

— from

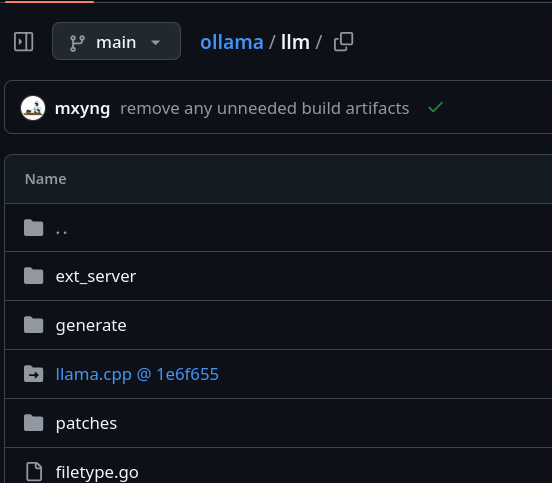

et la présence de Llama.cpp directement dans le code source de Ollama

Je comprends que pour le moment, Ollama supporte uniquement le backend Llama.cpp.

Conclusion : je pense qu’il est préférable d’utiliser Ollama plutôt que directement Llama.cpp.