Proxmox

Site officiel : https://www.proxmox.com

Documentation officielle : https://pve.proxmox.com/pve-docs/index.html

Liste de toutes les pages du wiki officiel : https://pve.proxmox.com/wiki/Special:AllPages

Le forum officiel : https://forum.proxmox.com/

Journaux liées à cette note :

Journal du dimanche 19 janvier 2025 à 11:24

#iteration Projet GH-271 - Installer Proxmox sur mon serveur NUC Intel i3-5010U, 8Go de Ram :

Être capable d'exposer sur Internet un port d'une VM.

Voici comment j'ai atteint cet objectif.

Pour faire ce test, j'ai installé un serveur http nginx sur une VM qui a l'IP 192.168.1.236.

Cette IP est attribuée par le DHCP installé sur mon routeur OpenWrt. Le serveur hôte Proxmox est configuré en mode bridge.

Ma Box Internet Bouygues sur 192.168.1.254 peut accéder directement à cette VM 192.168.1.236.

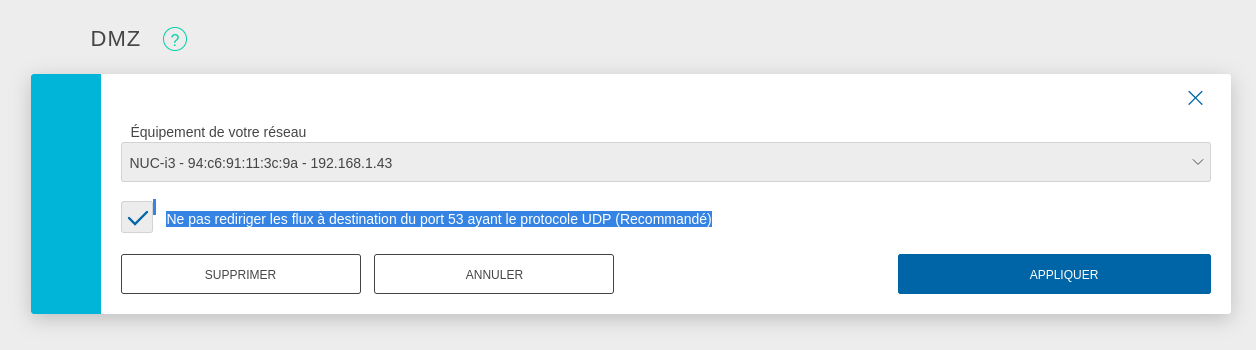

Pour exposer le serveur Proxmox sur Internet, j'ai configuré mon serveur Serveur NUC i3 gen 5 en tant que DMZ host.

J'ai suivi la recommandation pour éviter une attaque du type : DNS amplification attacks

DNS amplification attacks involves an attacker sending a DNS name lookup request to one or more public DNS servers, spoofing the source IP address of the targeted victim.

Avec cette configuration, je peux accéder en ssh au Serveur NUC i3 gen 5 depuis Internet.

J'ai tout de suite décidé d'augmenter la sécurité du serveur ssh :

# cat <<'EOF' > /etc/ssh/sshd_config.d/sklein.conf

Protocol 2

PasswordAuthentication no

PubkeyAuthentication yes

AuthenticationMethods publickey

KbdInteractiveAuthentication no

X11Forwarding no

# systemctl restart ssh

J'ai ensuite configuré le firewall basé sur nftables pour mettre en place quelques règles de sécurité et mettre en place de redirection de port du serveur hôte Proxmox vers le port 80 de la VM 192.168.1.236.

nftables est installé par défaut sur Proxmox mais n'est pas activé. Je commence par activer nftables :

root@nuci3:~# systemctl enable nftables

root@nuci3:~# systemctl start nftables

Voici ma configuration /etc/nftables.conf, je me suis fortement inspiré des exemples présents dans ArchWiki : https://wiki.archlinux.org/title/Nftables#Server

# cat <<'EOF' > /etc/nftables.conf

flush ruleset;

table inet filter {

# Configuration from https://wiki.archlinux.org/title/Nftables#Server

set LANv4 {

type ipv4_addr

flags interval

elements = { 10.0.0.0/8, 172.16.0.0/12, 192.168.0.0/16, 169.254.0.0/16 }

}

set LANv6 {

type ipv6_addr

flags interval

elements = { fd00::/8, fe80::/10 }

}

chain input {

type filter hook input priority filter; policy drop;

iif lo accept comment "Accept any localhost traffic"

ct state invalid drop comment "Drop invalid connections"

ct state established,related accept comment "Accept traffic originated from us"

meta l4proto ipv6-icmp accept comment "Accept ICMPv6"

meta l4proto icmp accept comment "Accept ICMP"

ip protocol igmp accept comment "Accept IGMP"

udp dport mdns ip6 daddr ff02::fb accept comment "Accept mDNS"

udp dport mdns ip daddr 224.0.0.251 accept comment "Accept mDNS"

ip saddr @LANv4 accept comment "Connections from private IP address ranges"

ip6 saddr @LANv6 accept comment "Connections from private IP address ranges"

tcp dport ssh accept comment "Accept SSH on port 22"

tcp dport 8006 accept comment "Accept Proxmox web console"

udp sport bootpc udp dport bootps ip saddr 0.0.0.0 ip daddr 255.255.255.255 accept comment "Accept DHCPDISCOVER (for DHCP-Proxy)"

}

chain forward {

type filter hook forward priority filter; policy accept;

}

chain output {

type filter hook output priority filter; policy accept;

}

}

table nat {

chain prerouting {

type nat hook prerouting priority dstnat;

tcp dport 80 dnat to 192.168.1.236;

}

chain postrouting {

type nat hook postrouting priority srcnat;

masquerade

}

}

EOF

Pour appliquer en toute sécurité cette configuration, j'ai suivi la méthode indiquée dans : "Appliquer une configuration nftables avec un rollback automatique de sécurité".

Après cela, voici les tests que j'ai effectués :

- Depuis mon réseau local :

- Test d'accès au serveur Proxmox via ssh :

ssh root@192.168.1.43 - Test d'accès au serveur Proxmox via la console web : https://192.168.1.43:8006

- Test d'accès au service http dans la VM :

curl -I http://192.168.1.236

- Test d'accès au serveur Proxmox via ssh :

- Depuis Internet :

Voilà, tout fonctionne correctement 🙂.

Prochaines étapes :

- Être capable d'accéder depuis Internet via IPv6 à une VM

- Je souhaite arrive à effectuer un déploiement d'une Virtual instance via Terraform

Journal du lundi 23 décembre 2024 à 19:39

J'ai commencé le Projet GH-271 - Installer Proxmox sur mon serveur NUC Intel i3-5010U, 8Go de Ram le 9 octobre.

Le 27 octobre, j'ai publié la note 2024-10-27_2109 qui contient une erreur qui m'a fait perdre 14h !

# virt-customize -a noble-server-cloudimg-amd64.img --install qemu-guest-agent --run-command 'systemctl enable qemu-guest-agent.service'

[ 0.0] Examining the guest ...

[ 4.5] Setting a random seed

virt-customize: warning: random seed could not be set for this type of

guest

[ 4.5] Setting the machine ID in /etc/machine-id

[ 4.5] Installing packages: qemu-guest-agent

[ 32.1] Running: systemctl enable qemu-guest-agent.service

[ 32.6] Finishing off

Je n'avais pas fait attention au message Setting the machine ID in /etc/machine-id 🙊.

Conséquence : le template Proxmox Ubuntu contenait un fichier /etc/machine-id avec un id.

Conséquence : toutes les Virtual machine que je créais sous Proxmox avaient la même valeur machine-id.

J'ai découvert que l'option 61 "Client identifier" du protocole DHCP permet de passer un client id au serveur DHCP qui sera utilisé à la place de l'adresse MAC.

Conséquence : le serveur DHCP assignait la même IP à ces Virtual machine.

J'ai pensé que le serveur DHCP de mon router BBox avait un problème. J'ai donc décidé d'installer Projet 15 - Installation et configuration de OpenWrt sur Xiaomi Mi Router 4A Gigabit pour avoir une meilleure maitrise du serveur DHCP.

Problème : j'ai fait face au même problème avec le serveur DHCP de OpenWrt.

Après quelques recherches, j'ai découvert que contrairement à virt-customize la commande virt-sysprep permet d'agir sur des images qui ont vocation à être clonées.

"Sysprep" stands for "system preparation" tool. The name comes from the Microsoft program sysprep.exe which is used to unconfigure Windows machines in preparation for cloning them.

Pour corriger le problème, j'ai remplacé cette ligne :

# virt-customize -a noble-server-cloudimg-amd64.img --install qemu-guest-agent --run-command 'systemctl enable qemu-guest-agent.service'

Par ces deux lignes :

# virt-sysprep -a noble-server-cloudimg-amd64.img --network --install qemu-guest-agent --run-command 'systemctl enable qemu-guest-agent.service'

# virt-sysprep --operation machine-id -a noble-server-cloudimg-amd64.img

La seconde commande permet de supprimer le fichier /etc/machine-id, ce qui corrige le problème d'attribution d'IP par le serveur DHCP.

À noter que je ne comprends pas pourquoi il est nécessaire de lancer explicitement cette seconde commande, étant donné que la commande virt-sysprep est destinée aux images de type "template". Le fichier /etc/machine-id ne devrait jamais être créé, ou tout du moins, automatiquement supprimé à la fin de chaque utilisation de virt-sysprep.

Maintenant, l'instanciation de Virtual machine fonctionne bien, elles ont des IP différentes 🙂.

Prochaine étape du Projet GH-271 :

Je souhaite arrive à effectuer un déploiement d'une Virtual instance via cli de Terraform.

Journal du dimanche 22 décembre 2024 à 18:11

Alexandre m'a partagé l'article "Proxmox - Activer les mises à jour sans abonnement (no-subscription)".

Élément que je retiens :

Le processus de validation des paquets chez Proxmox est le suivant : Test -> No-Subscription -> Enterprise. Le dépôt No-Suscription est donc suffisamment stable. L'avertissement est à mon avis pour mettre hors cause l'équipe de Proxmox en cas de trou dans la raquette lors des tests de validation.

$ ssh root@192.168.1.43

# cat <<EOF > /etc/apt/sources.list.d/proxmox.list

deb http://download.proxmox.com/debian/pve bookworm pve-no-subscription

EOF

# rm /etc/apt/sources.list.d/pve-enterprise.list

# rm /etc/apt/sources.list.d/ceph.list

# apt update -y

# apt upgrade -y

...

# reboot

Pour supprimer le message de warning au login, sur la version 8.3.2, j'ai appliqué le patch suivant :

# patch /usr/share/javascript/proxmox-widget-toolkit/proxmoxlib.js <<EOF

--- /usr/share/javascript/proxmox-widget-toolkit/proxmoxlib.js.old 2024-12-22 18:23:48.951557867 +0100

+++ /usr/share/javascript/proxmox-widget-toolkit/proxmoxlib.js 2024-12-22 18:18:50.509376748 +0100

@@ -563,6 +563,7 @@

let res = response.result;

if (res === null || res === undefined || !res || res

.data.status.toLowerCase() !== 'active') {

+ /*

Ext.Msg.show({

title: gettext('No valid subscription'),

icon: Ext.Msg.WARNING,

@@ -575,6 +576,7 @@

orig_cmd();

},

});

+ */

} else {

orig_cmd();

}

EOF

# systemctl restart pveproxy

Journal du samedi 02 novembre 2024 à 23:36

#JaiDécouvert Harvester qui me semble être une alternative moderne à Proxmox, basé sur KubeVirt et Longhorn.

J'ai regardé la vidéo Kubevirt: Et si Kubernetes orchestrait vos VMs? (Mickael ROGER) qui m'a découragé d'utiliser KubeVirt.

Journal du dimanche 27 octobre 2024 à 21:09

Nouvelle #iteration du Projet GH-271 - Installer Proxmox sur mon serveur NUC Intel i3-5010U, 8Go de Ram.

J'ai eu des difficultés à trouver comment déployer avec Proxmox des Virtual instance basées sur Ubuntu Cloud Image.

J'ai trouvé réponse à mes questions dans cet article : "Perfect Proxmox Template with Cloud Image and Cloud Init".

Mais depuis, j'ai trouvé un meilleur tutoriel : "Linux VM Templates in Proxmox on EASY MODE using Prebuilt Cloud Init Images!".

Création d'un template Ubuntu LTS

J'ai exécuté les commandes suivantes en SSH sur mon serveur NUC i3 pour créer un template de VM Proxmox.

root@nuci3:~# apt update -y && apt install libguestfs-tools jq -y

root@nuci3:~# wget https://cloud-images.ubuntu.com/noble/current/noble-server-cloudimg-amd64.img

Ancienne commande qui contient une erreur à ne pas utilisé, plus d'information dans la note 2024-12-23_1939 :

root@nuci3:~# virt-customize -a noble-server-cloudimg-amd64.img --install qemu-guest-agent --run-command 'systemctl enable qemu-guest-agent.service'

root@nuci3:~# virt-sysprep -a noble-server-cloudimg-amd64.img --network --install qemu-guest-agent --run-command 'systemctl enable qemu-guest-agent.service'

root@nuci3:~# virt-sysprep --operation machine-id -a noble-server-cloudimg-amd64.img

root@nuci3:~# qm create 8000 --memory 2048 --core 2 --name ubuntu-cloud-template --net0 virtio,bridge=vmbr0

root@nuci3:~# qm disk import 8000 noble-server-cloudimg-amd64.img local-lvm

transferred 3.5 GiB of 3.5 GiB (100.00%)

transferred 3.5 GiB of 3.5 GiB (100.00%)

Successfully imported disk as 'unused0:local-lvm:vm-8000-disk-0'

root@nuci3:~# rm noble-server-cloudimg-amd64.img

root@nuci3:~# qm set 8000 --scsihw virtio-scsi-pci --scsi0 local-lvm:vm-8000-disk-0

update VM 8000: -scsi0 local-lvm:vm-8000-disk-0 -scsihw virtio-scsi-pci

root@nuci3:~# qm set 8000 --ide2 local-lvm:cloudinit

update VM 8000: -ide2 local:cloudinit

Formatting '/var/lib/vz/images/8000/vm-8000-cloudinit.qcow2', fmt=qcow2 cluster_size=65536 extended_l2=off preallocation=metadata compression_type=zlib size=4194304 lazy_refcounts=off refcount_bits=16

ide2: successfully created disk 'local:8000/vm-8000-cloudinit.qcow2,media=cdrom'

generating cloud-init ISO

(liste des paramètres cloud-init)

root@nuci3:~# qm set 8000 --ipconfig0 "ip6=auto,ip=dhcp"

root@nuci3:~# qm set 8000 --sshkeys ~/.ssh/authorized_keys

root@nuci3:~# qm set 8000 --ciuser stephane

root@nuci3:~# qm set 8000 --cipassword password # optionnel, seulement en phase de debug

root@nuci3:~# qm set 8000 --boot c --bootdisk scsi0

update VM 8000: -boot c -bootdisk scsi0

root@nuci3:~# qm set 8000 --serial0 socket --vga serial0

update VM 8000: -serial0 socket -vga serial0

root@nuci3:~# qm set 8000 --agent enabled=1

root@nuci3:~# qm set 8000 --ciupgrade 0

root@nuci3:~# qm template 8000

Renamed "vm-8000-disk-0" to "base-8000-disk-0" in volume group "pve"

Logical volume pve/base-8000-disk-0 changed.

WARNING: Combining activation change with other commands is not advised.

Création d'une Virtual Instance

root@nuci3:~# qm clone 8000 100 --name server1

root@nuci3:~# qm start 100

root@nuci3:~# qm guest cmd 100 network-get-interfaces | jq -r '.[] | select(.name == "eth0") | .["ip-addresses"][0] | .["ip-address"]'

192.168.1.64

$ ssh stephane@192.168.1.64

The authenticity of host '192.168.1.64 (192.168.1.64)' can't be established.

ED25519 key fingerprint is SHA256:OJHcY3GHOsm3I4qcsYFc6V4qePNxVS4iAOBsDjeLM7o.

This key is not known by any other names.

Are you sure you want to continue connecting (yes/no/[fingerprint])? yes

Warning: Permanently added '192.168.1.64' (ED25519) to the list of known hosts.

Welcome to Ubuntu 24.04.1 LTS (GNU/Linux 6.8.0-45-generic x86_64)

...

Journal du mercredi 09 octobre 2024 à 23:52

#iteration Projet GH-271 - Installer Proxmox sur mon serveur NUC Intel i3-5010U, 8Go de Ram.

J'ai installé avec succès la version 8.2.2 de Proxmox sur mon Serveur NUC i3 gen 5.

J'ai copié l'image ISO de Proxmox sur une clé USB.

J'ai branché un clavier et un moniteur sur mon Serveur NUC i3 gen 5 et j'ai suivi la procédure d'installation sans rencontrer de difficulté.

Je peux me connecter au serveur via l'interface web de Proxmox ou directement via ssh.

Prochaine étape : déployer une Virtual instance Ubuntu LTS.

Journal du samedi 07 septembre 2024 à 19:32

#JeMeDemande souvent comment nommer la méthode permettant d'installer des applications de manière scriptée.

Lorsque je recherche cette fonctionnalité, j'utilise généralement les mots-clés : "headless", "script", "cli".

Je constate que la roadmap de Proxmox utilise le terme « automated and unattended installation » :

Support for automated and unattended installation of Proxmox VE.

-- from

#JaiPublié cette question dans la section discussion du projet Plausible : Plausible automated and unattended installation support (create user and web site by script) · plausible/analytics.

Journal du vendredi 28 janvier 2022 à 20:00

J'ai acheté un Serveur NUC i3 gen 5 d'occasion pour 150 € sur LeBonCoin, avec pour objectif de l'utiliser comme serveur Homelab.

Je prévois d'y installer Proxmox pour déployer des Virtual Instances.