btrfs

Voir aussi filesystem XFS.

Journaux liées à cette note :

Toujours utiliser unlink pour supprimer un lien symbolique, ne jamais utiliser rm

Je viens de perdre bêtement la configuration de mon playground LazyVim.

J'utilise ce lien symbolique comme documenté ici :

$ ls -l ~/.config/lazyvim-playground

/home/stephane/.config/lazyvim-playground -> /home/stephane/git/github.com/stephane-klein/lazyvim-playground/config

J'ai voulu nettoyer ma configuration avec mise clean, qui a exécuté :

$ rm -rf ~/.config/lazyvim-playground/

Problème : avec le / à la fin, cette commande ne supprime pas le lien symbolique mais efface tous les fichiers présents dans la cible du lien ! Pour supprimer uniquement le lien, il faut retirer le /.

Leçon de cette erreur : ne jamais utiliser rm pour supprimer un lien symbolique, toujours utiliser unlink :

$ unlink ~/.config/lazyvim-playground/

Je vais profiter de cette erreur pour explorer snapper et timeshift afin de mettre en place un système de snapshot automatique de ma partition /home/ basé sur les fonctionnalités de btrfs.

composefs, un filesystem spécialement créé pour les besoins des distributions atomic

Cette note fait partie de la série de notes : "J'ai étudié et testé CoreOS et je suis tombé dans un rabbit hole 🙈".

Note précédente : "Quelques outils CoreOS : coreos-installer, graphe de migration et zincati".

En 2021, Alexander Larsson a initié composefs, un nouveau filesystem. Pour faire simple, composefs permet de monter un filesystem depuis un checkout libostree.

composefs est un filesystem de type "stacking filesystem" qui combine plusieurs technologies :

- EROFS : fournit la couche read-only et l'efficacité de stockage

- overlayfs : gère la superposition de layers

- fs-verity : assure la vérification d'intégrité des fichiers à la volée

Avec libostree seul (sans composefs), les checkout s'appuient sur des hardlinks vers un store central. Cette approche économise de l'espace disque, mais présente deux limitations :

- L'utilisateur

rootpeut modifier les fichiers et corrompre le store partagé - Il n'y a pas de vérification d'intégrité lors de l'accès aux fichiers

Grâce à EROFS, un filesystem read-only, la structure de fichier checkout devient immuable, ces fichiers ne sont plus des hardlink.

composefs a l'avantage de pouvoir utiliser différents filesystèmes comme couche de stockage : ext4, XFS, btrfs, etc.

Comme l'explique Alexander Larsson dans ce post de 2022, le second objectif de composefs est d'adresser une limitation de sécurité d'OSTree identifiée par Lennart Poettering : les fichiers gérés par libostree ne sont vérifiés qu'au moment de leur téléchargement, pas lors de leur utilisation.

Grâce à fs-verity (une fonctionnalité du kernel Linux), composefs permet la vérification cryptographique des fichiers à chaque accès (runtime verification). Cette approche peut détecter toute modification ou corruption au moment de l'utilisation du fichier. Je précise que je maîtrise assez mal cette partie sécurité.

Pour approfondir le sujet composefs, je vous conseille l'article lwn "Composefs for integrity protection and data sharing " de décembre 2022 ou encore tous les billets de Alexander Larsson au sujet de composefs, ainsi que ce "OSTree and composefs tutorial" qui m'a aidé à mieux comprendre par la pratique.

composefs a été intégré dans la version 41 de Fedora CoreOS et la version 42 de Fedora Silverblue. Voici une vérification de la présence de composefs sous CoreOS :

stephane@stephane-coreos:~$ ostree --version

libostree:

Version: '2025.4'

Git: 99a03a7bb8caa774668222a0caace3b7e734042e

Features:

- inode64

- initial-var

- libcurl

- libsoup3

- gpgme

- composefs <==== ici

- ex-fsverity

- libarchive

- selinux

- openssl

- sign-ed25519

- sign-spki

- libmount

- systemd

- release

- p2p

stephane@stephane-coreos:~$ mount | grep -i composefs

composefs on / type overlay (ro,relatime,seclabel,lowerdir+=/run/ostree/.private/cfsroot-lower,datadir+=/sysroot/ostree/repo/objects,redirect_dir=on,metacopy=on)

Note suivante : "L'utilisation de OSTree par Flatpak".

Système de mise à jour d'Android, Chrome OS, MacOS et MS Windows

Cette note fait partie de la série de notes : "J'ai étudié et testé CoreOS et je suis tombé dans un rabbit hole 🙈".

Note précédente : "Ajout de packages dans des distributions atomiques".

Chrome OS et Android implémentent la stratégie de double partition A/B (seamless) system updates.

Cette technologie offre des mises à jour complètement transparentes en arrière-plan et un redémarrage immédiat.

En revanche, contrairement à la solution CoreOS (méthode détaillée dans cette note), cette méthode a pour inconvénient de consommer deux fois plus d'espace de stockage.

MacOS s'appuie sur les snapshots de son filesystem APFS (fonctionnalité qu'offre aussi btrfs). Cela garantit un retour en arrière rapide vers la version antérieure si des problèmes surviennent.

En revanche, l'upgrade se termine durant le reboot, pouvant prendre de 2 à 5 minutes, alors que le redémarrage reste instantané avec Chrome OS, Android, CoreOS ou Fedora Silverblue.

Comme d'habitude, je n'arrive pas à trouver des informations précises sur le fonctionnement interne de MS Windows 😔. D'après Claude Sonnet 4, le système de mise à jour de Windows 10 et Windows 11, baptisé Unified Update Platform (UUP), semble plutôt daté : pas d'A/B (seamless) system updates, absence d'atomicité, installation longue lors du reboot (10 à 30 minutes), possibilité d'échec en cours de processus, rollback complexe, aucun système de snapshot comparable à MacOS. J'ai du mal à croire ce bilan tellement catastrophique, ce qui m'amène à questionner sur l'exactitude des informations rapportées par Claude Sonnet 4.

D'après cette documentation particulièrement riche et mes recherches complémentaires, je pense que la stack libostree + composefs (avec zstd:chunked ) tel qu'implémenté dans Fedora CoreOS est probablement la technologie de mise à jour la plus avancée actuellement disponible.

Avant de présenter le fonctionnement du système de mise à jour de Fedora CoreOS en 2025, je vais retracer l'évolution technique de cette solution.

Note suivante : "CoreOS de 2013 à 2018".

Journal du vendredi 18 avril 2025 à 11:40

Cela fait des années que je m'intéresse au sujet des solutions de sauvegarde en continu de bases de données PostgreSQL.

Dans cette note, le terme "sauvegarde en continu" ne signifie pas Point In Time Recovery.

Jusqu'à présent, je me suis toujours concentré sur la méthode "mainstream", qui consiste principalement à effectuer un backup binaire couplé avec une sauvegarde continue du WAL. Par exemple des solutions basées sur pg_basebackup, pgBackRest ou barman.

Une autre solution consiste à déployer une seconde instance PostgreSQL en mode streaming replication.

Une troisième solution que #JaimeraisUnJour tester : mettre en place une sauvegarde incrémentale basée sur le filesystème btrfs.

Plus précisément, la commande btrfs-send. La documentation de Dalibo mentionne cette méthode de sauvegarde.

Samedi dernier, j'ai imaginé une autre méthode qui me plait beaucoup par sa relative flexibilité et sa simplicité.

Elle consisterait à sauvegarder des tables de manière granulaire à intervalle de temps régulier vers un Object Storage à l'aide d'un Foreign Data Wrapper.

Pour cela, j'ai identifié parquet_s3_fdw, basé sur le format Apache Parquet qui permet de lire et d'écrire des données sur un bucket Object Storage.

Features

- Support SELECT of parquet file on local file system or Amazon S3.

- Support INSERT, DELETE, UPDATE (Foreign modification).

- Support MinIO access instead of Amazon S3.

J'ai utilisé de nombreuses fois Foreign Data Wrapper pour copier de manière granulaire des données entre deux bases de données PostgreSQL.

J'ai trouvé cette méthode très pratique, en particulier la possibilité de pouvoir utiliser un "pattern" SQL de copie du type :

INSERT INTO clients_local (id, nom, email, date_derniere_maj)

SELECT

d.client_id,

d.nom_client,

d.email_client,

CURRENT_TIMESTAMP

FROM

distant.clients_distant d

WHERE

d.date_modification > (SELECT MAX(date_derniere_maj) FROM clients_local)

ON CONFLICT (id) DO UPDATE

SET

nom = EXCLUDED.nom,

email = EXCLUDED.email,

date_derniere_maj = EXCLUDED.date_derniere_maj;

#JaimeraisUnJour réaliser un POC de cette idée basée sur parquet_s3_fdw.

Je découvre la compression Zstandard

Un ami m'a partagé Zstandard (zstd), un algorithme de compression.

Il y a 2 ans, j'ai étudié et activé Brotli dans mes containers nginx, voir la note : Mise en œuvre du module Nginx Brotli.

Je viens de trouver un module zstd pour nginx : https://github.com/tokers/zstd-nginx-module

Mon ami m'a partagé cet excellent article : Choosing Between gzip, Brotli and zStandard Compression. Très complet, il explique tout, contient des benchmarks…

Voici ce que je retiens.

Brotli a été créé par Google, Zstandard par Facebook :

Je lis sur canIuse, le support Zstandard a été ajouté à Chrome en mars 2024 et à Firefox en mai 2024, c'est donc une technologie très jeune coté browser.

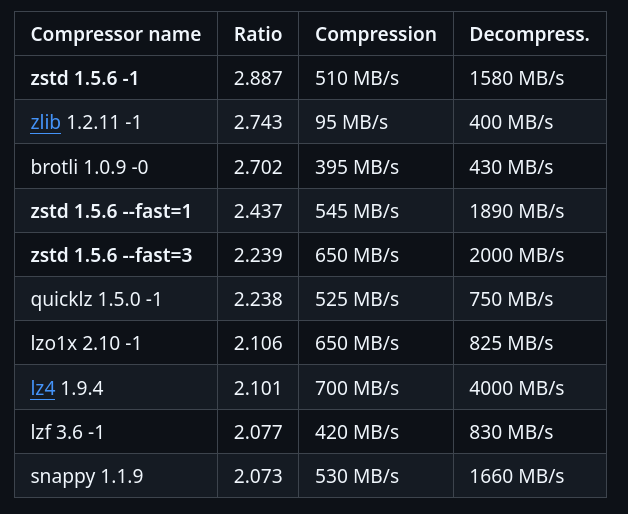

Benchmark sur le dépôt officiel de Zstandard :

J'ai trouvé ces threads Hacker News :

- 2020-05-07 : Introduce ZSTD compression to ZFS

- 2022-08-20 : AWS switch from gzip to zstd – about 30% reduction in compressed S3 storage

Zstandard semble être fortement adopté au niveau de l'écosystème des OS Linux :

In March 2018, Canonical tested the use of zstd as a deb package compression method by default for the Ubuntu Linux distribution. Compared with xz compression of deb packages, zstd at level 19 decompresses significantly faster, but at the cost of 6% larger package files. Support was added to Debian in April 2018

Packages Fedora :

#JeMeDemande si dans mes projets de doit utiliser Zstandard plutôt que Brotli 🤔.

Je pense avoir trouver une réponse ici :

The research I’ve shared in this article also shows that for many sites Brotli will provide better compression for static content. Zstandard could potentially provide some benefits for dynamic content due to its faster compression speeds. Additionally:

- ...

- For dynamic content

- Brotli level 5 usually result in smaller payloads, at similar or slightly slower compression times.

- zStandard level 12 often produces similar payloads to Brotli level 5, with compression times faster than gzip and Brotli.

- For static content

- Brotli level 11 produces the smallest payloads

- zStandard is able to apply their highest compression levels much faster than Brotli, but the payloads are still smaller with Brotli.

#JaimeraisUnJour prendre le temps d'installer zstd-nginx-module à mon image Docker nginx-brotli-docker (ou alors d'en trouver une déjà existante).