Filtre actif, cliquez pour en enlever un tag :

Cliquez sur un tag pour affiner votre recherche :

Résultat de la recherche (23 notes) :

Journal du mercredi 24 décembre 2025 à 14:59

Un ami vient de me poser cette question :

tu es content de Mammouth ? ça s'intègre bien à Zed, VSCode ?

Il fait probablement référence à ma note du 2025-11-16_1325.

Comme je l'indiquais à l'époque :

J'ai pris un abonnement d'un mois à 12 € TTC pour tester le service. Pour l'instant, je pense continuer avec le couple Open WebUI et OpenRouter qui me donne accès à plus de modèles et plus de flexibilité.

Finalement, je n'ai pas utilisé Mammouth et je suis resté sur le couple Open WebUI et OpenRouter.

Par ailleurs, je n'ai jamais essayé Zed editor et je n'utilise plus VS Code depuis mi-2022 (voir Historique des éditeurs texte que j'ai utilisés).

Voici ce que j'utilise depuis début 2025 pour les LLM :

Au quotidien, j'utilise Open WebUI connecté à OpenRouter pour accéder à différents modèles LLM (voir Quelle est mon utilisation d'OpenRouter.ia ?).

Pour les AI code assistant, j'ai d'abord utilisé avante.nvim, puis depuis quelques mois j'utilise principalement Aider.

Par exemple, j'ai implémenté 90% du projet qemu-compose avec Aider (voir section Development approach).

J'utilise aussi llm (cli), mais sans doute pas encore assez.

Ce que j'envisage de tester :

- AIChat pour remplacer llm (cli) et potentiellement Open WebUI

- Claude Code pour le comparer à Aider

- Avante Zen Mode pour éventuellement remplacer Aider

- LibreChat pour potentiellement remplacer Open WebUI

Avec AIChat et LibreChat, je souhaite commencer à utiliser sérieusement les tools (LLM) et des services MCP.

Ce que je compte conserver : OpenRouter.

Script d'analyse des coûts Aider à partir de l'historique

J'ai cherché une fonctionnalité pour calculer le coût total de l'utilisation d'Aider sur un projet. Je n'ai rien trouvé dans la documentation ni dans les issues du projet Aider.

Je sais qu'Aider enregistre toutes les informations de session dans .aider.chat.history.md.

Ce fichier contient des lignes du type : "Tokens: 49k sent, 1.9k received. Cost: $0.17 message, $1.68 session".

À partir de ces informations, j'ai généré avec Claude Sonnet 4.5 le script Python aider_cost_analyzer.py.

Installation sous Fedora :

$ mkdir -p ~/.local/bin

$ curl -o ~/.local/bin/aider_cost_analyzer.py https://gist.githubusercontent.com/stephane-klein/3b3808c1b03b7e6ddfc4b22b69fdf776/raw/4262faec0cb2f468ea6b6d8751339b8e8497f005/aider_cost_analyzer.py

$ chmod +x ~/.local/bin/aider_cost_analyzer.py

Exemple d'utilisation :

$ aider_cost_analyzer.py .

Analyzing 1 history file(s) in '.':

.aider.chat.history.md:

Messages: 30

Tokens sent: 639,200 | received: 65,613

Cost: $1.86

============================================================

Total tokens sent: 639,200

Total tokens received: 65,613

Total cost: $1.86

J'ai posté l'issue suivante dans le repository aider-ce : "Calculate cumulative token usage and cost across all Aider sessions".

Journal du vendredi 21 novembre 2025 à 12:03

Dans ce thread, #JaiDécouvert OpenCode (https://github.com/sst/opencode) qui semble être une alternative à Aider et Claude Code.

Après avoir parcouru la documentation, j'ai l'impression qu'OpenCode propose des fonctionnalités et une User experience plus avancées qu'Aider.

Le projet est récent (démarré en mars 2025) et publié sous licence MIT.

D'après le footer du site de documentation, je comprends qu'OpenCode est développé par l'entreprise Anomaly, financée par du Venture capital.

#JaiLu ce commentaire à propos d'OpenCode dans les issues d'Aider.

En cherchant sur Hacker News, je suis tombé sur ce thread de juillet 2025.

J'ai retenu ce commentaire :

Two big differences:

opencode is much more "agentic": It will just take off and do loads of stuff without asking, whereas aider normally asks permission to do everything. It will make a change, the language server tells it the build is broken, it goes and searches for the file and line in the error message, reads it, and tries to fix it; rinse repeat, running (say) "go vet" and "go test" until it doesn't see anything else to do. You can interrupt it, of course, but it won't wait for you otherwise.

aider has much more specific control over the context window. You say exactly what files you want the LLM to be able to see and/or edit; and you can clear the context window when you're ready to move on to the next task. The current version of opencode has a way to "compact" the context window, where it summarizes for itself what's been done and then (it seems) drops everything else. But it's not clear exactly what's in and out, and you can't simply clear the chat history without exiting the program. (Or if you can, I couldn't find it documented anywhere.)

Je retiens donc qu'Aider offre un contrôle plus précis qu'OpenCode. OpenCode fonctionne de manière plus autonome.

Pour ma part, je préfère contrôler finement les actions d'un AI code assistant sur mon code, à la fois pour comprendre ses interventions et pour gérer ma consommation de tokens.

Je n'ai pas envie de tester OpenCode pour le moment, je vais continuer avec Aider.

Dans l'épisode "141 L’IA c’est comme les patates, il faut la faire garder pour la faire adopter" du podcast Clever Cloud, #JaiDécouvert la spécification agents.md (https://agents.md).

J'ai l'impression que AGENTS.md ressemble à la fonctionnalité CONVENTIONS.md du projet Aider.

J'ai trouvé une issue à ce sujet dans le projet Aider : Does Aider support AGENT.md or PLAN.md?.

Journal du dimanche 11 mai 2025 à 14:19

J'utilise Avante.nvim depuis le 12 janvier 2025. Je suis très satisfait, je trouve l'utilisation de cet outil agréable, bien que je sache que je maitrise seulement une petite partie de ses fonctionnalités.

Par exemple, je n'ai pas pris le temps de configurer la fonctionnalité RAG, ni la fonctionnalité Web Search Engines de avante.nvim.

Cela fait plusieurs semaines que je tombe sur le projet open-source aider.chat (https://aider.chat)

Aider lets you pair program with LLMs to start a new project or build on your existing codebase.

J'ai découvert ce projet ici le 20 avril 2025.

D'après ce que je comprends, Aider entre dans la catégorie des Terminaux Agents, comme par exemple Claude Code sortie en février 2025 ou OpenAI Codex CLI sorti en avril 2025.

Aider créé en 2023 par Paul Gauthier semble être un précurseur.

J'ai l'impression que les Terminaux Agents ont une plus large latitude d'action que les AI IDEs.

Journal du samedi 22 février 2025 à 18:14

Pour le moment, le seul reproche que je peux faire à avante.nvim, c'est que je ne peux pas utiliser Neovim (me balader dans le code, éditer un fichier) pendant qu'une réponse est en train d'être rédigée dans la sidebar.

J'ai trouvé cette issue qui semble correspondre à ce problème : feature: Cursor Movement Issue During Chat Response Generation.

Je viens de poster ce message, pour indiquer que je pense que ce problème est plus ou moins corrigé. J'arrive à déplacer librement mon curseur pendant la génération de réponse par avante.nvim.

Toutefois, la saisie de texte reste lente.

Journal du mardi 28 janvier 2025 à 15:26

D'ici quelques jours, je prévois de rédiger un bilan d'utilisation de avante.nvim pour faire le point sur mon expérience avec cet outil.

Après 16 jours d'utilisation d'avante.nvim et comme je le disais dans cette note mon retour est positif, mis à part le bug suivant : bug: non-streaming output never shows.

Pour le moment, je n'arrive pas à comprendre dans quelle condition ce bug arrive 🤔.

Je n'ai pas encore pris le temps de creuser le sujet. J'espère que l'issue va rapidement être résolue. 🤞.

Journal du vendredi 17 janvier 2025 à 19:02

D'ici quelques jours, je prévois de rédiger un bilan d'utilisation de avante.nvim pour faire le point sur mon expérience avec cet outil.

Après 5 jours d'utilisation, mon retour est positif. Je trouve avante.nvim très agréable à utiliser et GitHub Copilot avec Claude Sonnet 3.5 m'assiste efficacement 🙂.

Pour le moment, le seul reproche que je peux faire à avante.nvim, c'est que je ne peux pas utiliser Neovim (me balader dans le code, éditer un fichier) pendant qu'une réponse est en train d'être rédigée dans la sidebar.

J'ai trouvé cette issue qui semble correspondre à ce problème : feature: Cursor Movement Issue During Chat Response Generation.

J'ai réussi à configurer Avante.nvim connecté à Claude Sonnet via le provider Copilot

Note d' #iteration du Projet 21 - "Rechercher un AI code assistant qui ressemble à Cursor mais pour Neovim".

J'ai réussi à installer avante.nvim, voici le commit de changement de mon dotfiles : "Add Neovim Avante AI Code assistant".

Suite à la lecture de :

Since auto-suggestions are a high-frequency operation and therefore expensive, it is recommended to specify an inexpensive provider or even a free provider: copilot

et ma note 2025-01-12_2026, #JaiDécidé de connecter avante.nvim à GitHub Copilot.

J'ai suivi les instructions de README.md de avante.nvim et voici les difficultés que j'ai rencontrées.

Contexte : j'utilise lazy.nvim avec la méthode kickstart.nvim.

- Ici j'ai appliqué cette configuration :

opts = {

provider = "copilot",

auto_suggestions_provider = "copilot",

copilot = {

model = "claude-3.5-sonnet"

}

},

- Ce commentaire n'indique pas explicitement que je devais ajouter ici cette initialisation de copilot.lua :

{

"zbirenbaum/copilot.lua",

config = function()

require("copilot").setup({})

end

},

Après installation des plugins (Lazy sync), il faut lancer :Copilot auth pour initialiser l'accès à votre instance de GitHub Copilot. C'est très simple, il suffit de suivre les instructions à l'écran.

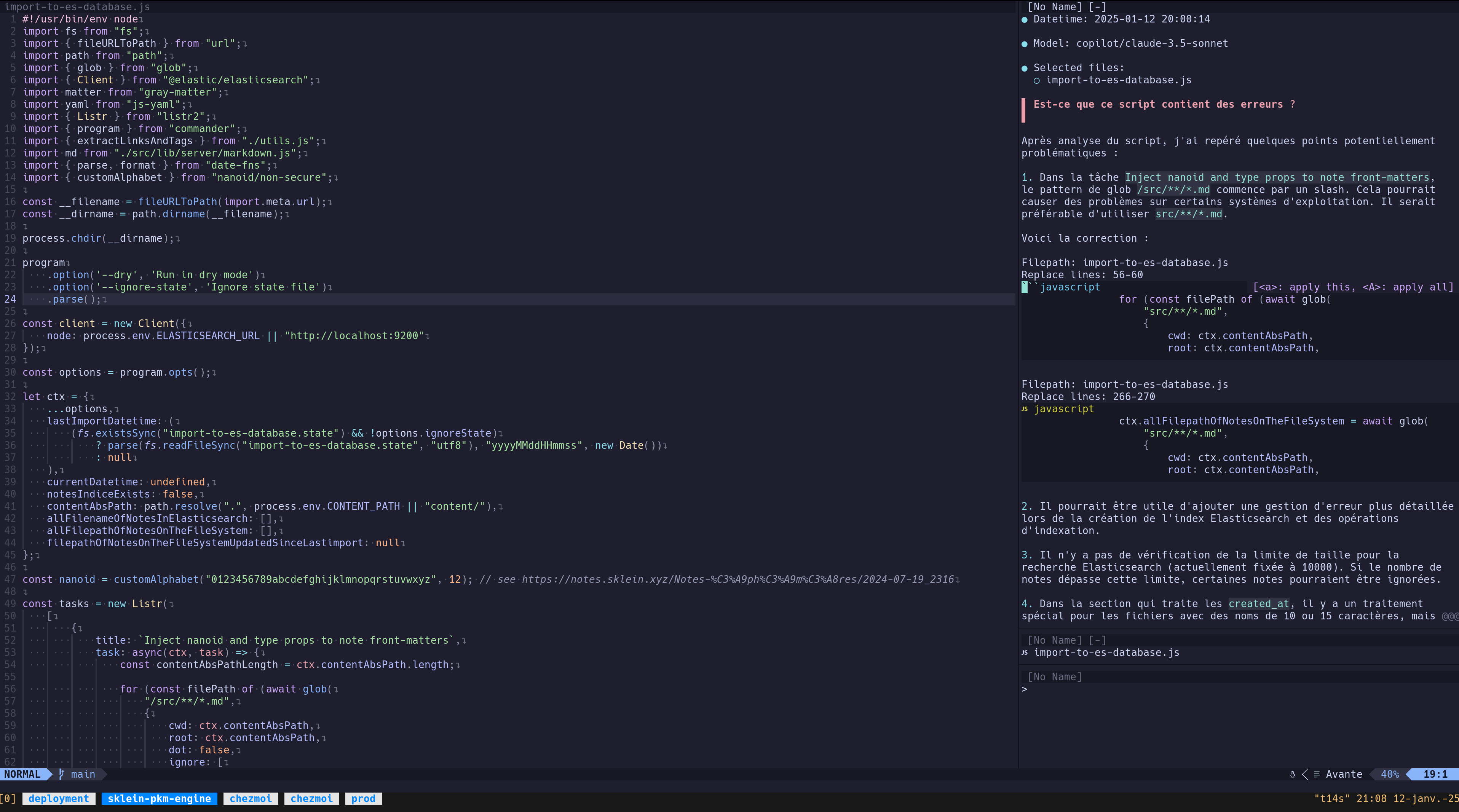

Pour le moment, j'ai uniquement fait un test de commentaire d'un script : « Est-ce que ce script contient des erreurs ? » :

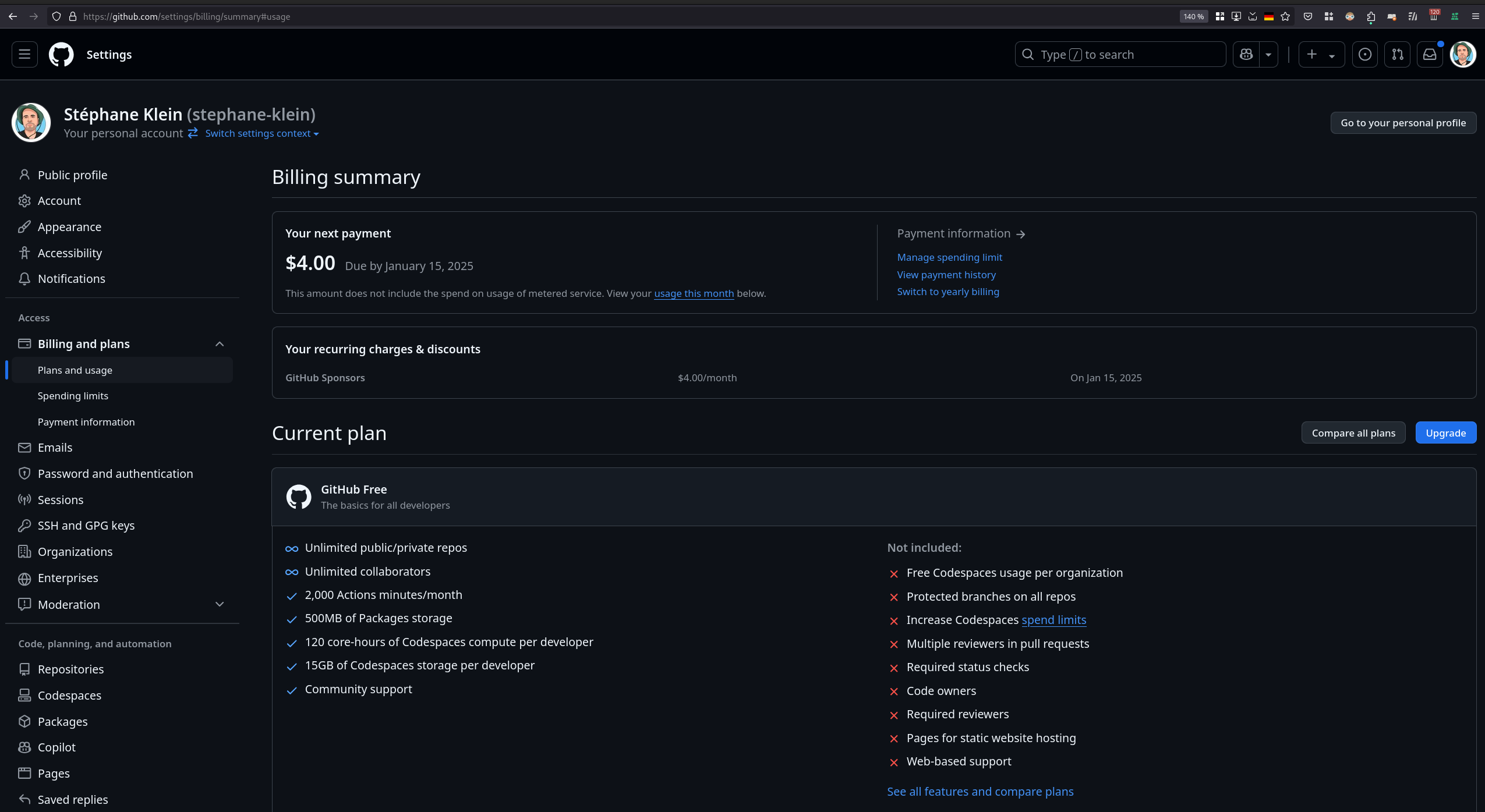

J'ai ensuite tenté de consulter mon rapport d'utilisation de GitHub Copilot pour vérifier l'état de mes quotas, mais je n'ai pas réussi à trouver ces informations :

D'ici quelques jours, je prévois de rédiger un bilan d'utilisation de avante.nvim pour faire le point sur mon expérience avec cet outil.

Journal du dimanche 12 janvier 2025 à 20:26

Suite à la lecture de :

Since auto-suggestions are a high-frequency operation and therefore expensive, it is recommended to specify an inexpensive provider or even a free provider: copilot

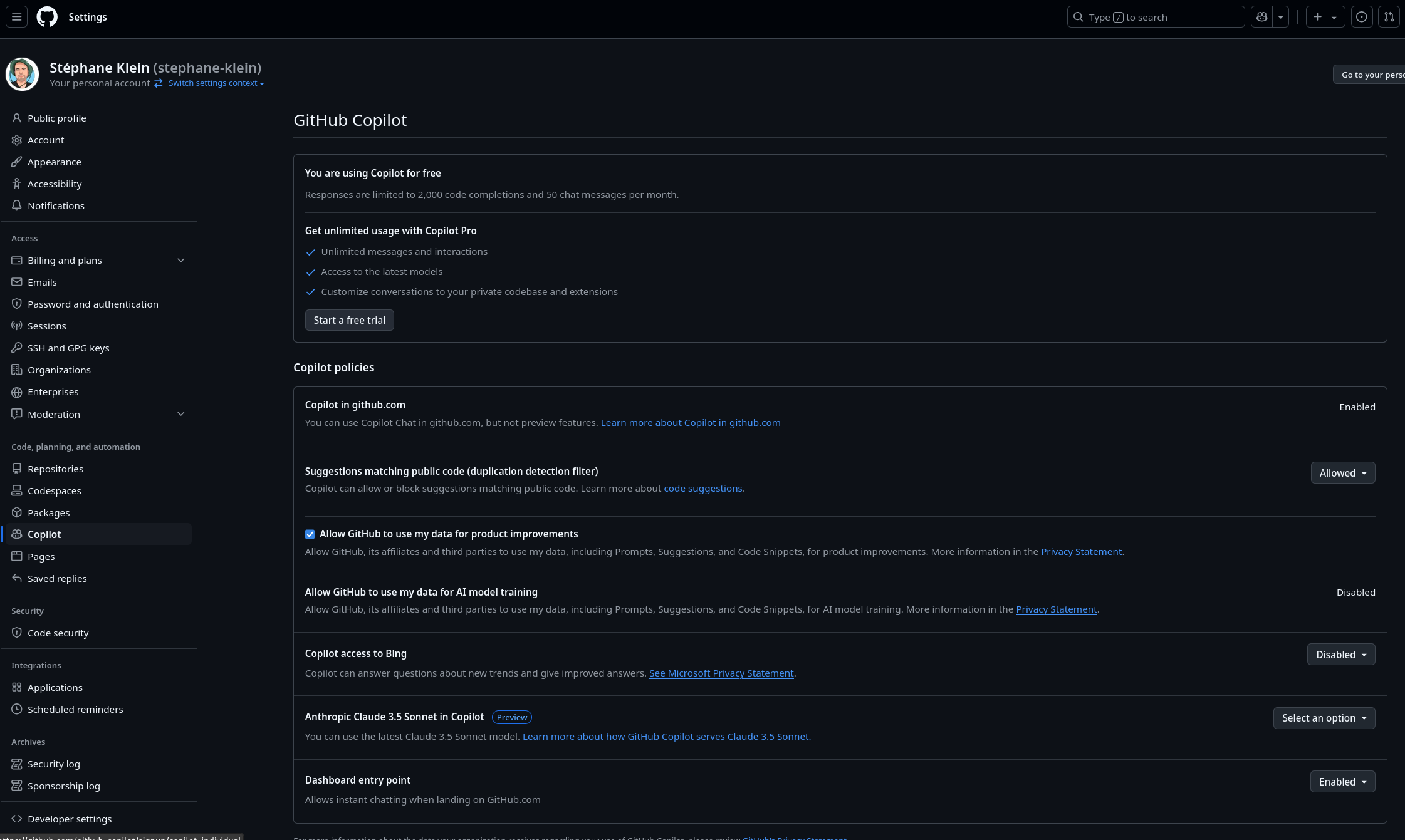

j'ai un peu étudié GitHub Copilot.

J'ai commencé par lire l'article Wikipedia "Microsoft Copilot" pour creuser pour la première fois ce sujet. Jusqu'à présent, Copilot était pour moi synonyme de GitHub Copilot, mais je me trompais totalement !

#JaiLu l'article Wikipedia GitHub Copilot.

J'ai ensuite parcouru les dernières entrées de GitHub Changelog.

- #JaiDécouvert que OpenAI o1 est déjà disponible dans GitHub Copilot : OpenAI o1 is now available in GitHunb Models.

Il y a quelques jours, j'avais vu le thread Hacker News : GitHub Copilot is now available for free

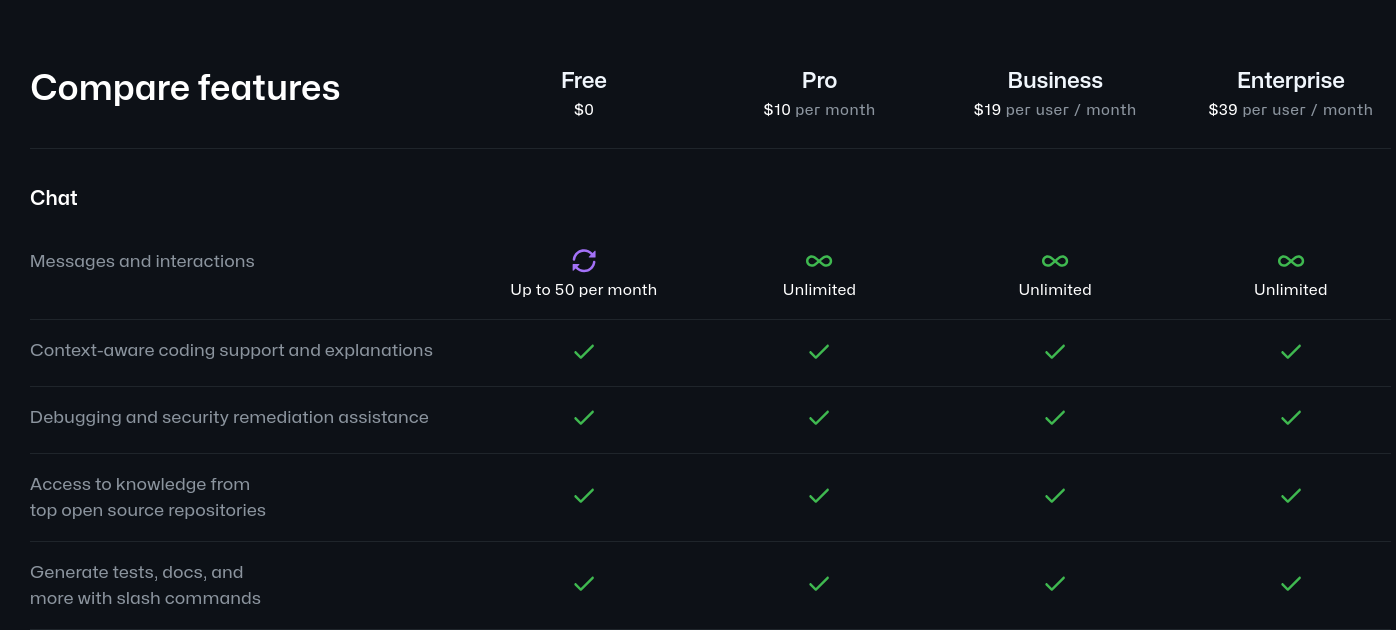

J'ai l'impression que « 50 messages and interactions » est très peu… mais tout de même utile pour tester comment cela fonctionne.

Par contre je trouve que 10 dollars par mois en illimité est très abordable.

Je découvre ici que Microsoft supporte officiellement un plugin GitHub Copilot pour Neovim : copilot.vim.

Je découvre la page de paramétrage de GitHub Copilot : https://github.com/settings/copilot

Journal du dimanche 12 janvier 2025 à 00:14

Voici mes prochaines #intentions d'amélioration de ma workstation :

- Après avoir observé l'environement desktop d'Alexandre, cela m'a donné envie de tester Zen Browser.

- Installer, configurer et tester Ghostty.

- Étudier, installer, configurer un AI code assistant qui ressemble à Cursor mais pour Neovim, voici-ci les plugins que j'aimerais tester :

- Peut-être apprendre à utiliser Jujutsu - A Git-compatible VCS that is both simple and powerful.

- J'aimerais trouver un équivalent à rofi ou fuzzel pour GNOME Shell.

#JeMeDemande si la fonctionnalité "GNOME Shell Search Provider" me permettrait de réaliser cet objectif 🤔.

Ou alors, est-ce que GNOME Shell permet nativement de lancer des scripts shells 🤔. - Essayer de remplacer les services ChatGPT ou Claude.ia par Open WebUI.

- Peut-être remplacer zsh par fish shell.

Journal du samedi 11 janvier 2025 à 23:25

#JaiDécouvert "Void", une alternative à l'éditeur de code "Cursor" : "Show HN: Void, an open-source Cursor/GitHub Copilot alternative ".

Dans les commentaires, #JaiDécouvert Supermaven, mais je n'ai pas pris le temps de l'étudier.

Journal du samedi 31 août 2024 à 17:29

Alexandre m'a partagé Continue.

Continue is the leading open-source AI code assistant. You can connect any models and any context to build custom autocomplete and chat experiences inside VS Code and JetBrains

Je lis ici que ce projet peut être assimilé à avante.nvim ou llm.nvim.

Je constate qu'il est possible de connecter Continue à beaucoup de types de LLM : Model Providers.

D'autre part, chose intéressante, Continue permet d'intégrer facilement du contexte provenant de diverses sources, telles que :

Je me pose toujours la même question que le 27 août :

Cependant, une question me revient sans cesse à l'esprit en voyant ce genre d'outil utilisant les API d'AI Provider : est-ce que le coût d'utilisation de ce type de service ne risque pas d'être exorbitant ? 🤔 Je sais bien que ces AI Provider permettent de définir un plafond de dépenses, ce qui est rassurant. La meilleure approche serait donc de tester l'outil et d'évaluer les coûts mensuels pour voir s'ils restent raisonnables.

Journal du mardi 27 août 2024 à 10:17

Alexandre m'a partagé avante.nvim.

#JaimeraisUnJour le setup pour le tester.

Cependant, une question me revient sans cesse à l'esprit en voyant ce genre d'outil utilisant les API d'AI Provider : est-ce que le coût d'utilisation de ce type de service ne risque pas d'être exorbitant ? 🤔

Je sais bien que ces AI Provider permettent de définir un plafond de dépenses, ce qui est rassurant. La meilleure approche serait donc de tester l'outil et d'évaluer les coûts mensuels pour voir s'ils restent raisonnables.

Article Wikipedia : https://fr.wikipedia.org/wiki/GitHub_Copilot

Cursor est un éditeur de code qui intègre un AI code assistant.

Site officiel : https://www.cursor.com/

Article Wikipedia : https://fr.wikipedia.org/wiki/Microsoft_Copilot

Dépôt GitHub : https://github.com/olimorris/codecompanion.nvim

Dépôt GitHub : https://github.com/github/copilot.vim

Voir aussi la version Lua pour Neovim : https://github.com/zbirenbaum/copilot.lua

Documentation officielle : https://docs.anthropic.com/en/docs/claude-code/overview

Projet 21 - "Rechercher un AI code assistant qui ressemble à Cursor mais pour Neovim"

Date de la création de cette note : 12 janvier 2025.

Quel est l'objectif de ce projet ?

Étudier, installer et configurer un AI code assistant qui ressemble à Cursor mais pour Neovim.

- avante.nvim (https://github.com/yetone/avante.nvim)

- codecompanion.nvim (https://github.com/olimorris/codecompanion.nvim)

Pourquoi je souhaite réaliser ce projet ?

J'avais déjà envie de tester avante.nvim en août 2024.

Je constate que depuis plus de 6 mois, j'utilise de plus en plus ChatGPT ou Claude.ia lorsque je code ou je rédige des textes. Rien que pour la dernière semaine, j'ai compté 7 conversations par jour.

Je constate aussi que mon expérience utilisateur n'est pas optimale : je dois effectuer de nombreux copier-coller pour donner du contexte à l'agent conversationnel.

Je lui donne du code source, je lui indique le nom des fichiers…

#JeMeDemande aussi si l'agent conversationnel pourrait me donner de meilleures réponses s'il a accès à l'intégralité du code source de projet 🤔.

Fonctionnalités

Exemples de tâches que j'aimerais facilement effectuer avec le AI code assistant, directement dans Neovim :

- Avoir des suggestions de code sur des projets : Javascript, TypeScript, Bash, Ansible, Svelte, Tailwind CSS

- Avoir des suggestions de corrections de bug

- Génération de message de Git commit à partir du contenu modifié et d'une explication du commit que j'aurais rédigé en français

- Suggestion / correction de documentation en Markdown, en anglais et français

- Suggestion de namming de variables

- Suggestion de refactoring

- Me donner les explications macro ou micro d'un projet

- Correction de fautes d'orthographe et de grammaire en français et anglais

Les questions que je me pose

Comme je le disais en août 2024 :

Cependant, une question me revient sans cesse à l'esprit en voyant ce genre d'outil utilisant les API d'AI Provider : est-ce que le coût d'utilisation de ce type de service ne risque pas d'être exorbitant ? 🤔

#JeMeDemande combien un AI code assistant va me coûter par mois 🤔.

Sur la page de pricing de Cursor, je lis :

$20/month :

- Unlimited completions

- 500 fast premium requests per month

- Unlimited slow premium requests

- 10 o1-mini uses per day

#JeMeDemande si Cursor a des réductions sur les volumes ou si je peux avoir le même prix en utilisant directement les API des AI Provider OpenAI ou Anthropic.

Est-ce que la location d'un serveur GPU sur Vast.ai pourrait être un choix plus économique 🤔.

Choix de modèle

#JeMeDemande quel modèle AI code assistant offre le meilleur rapport coût/performance ? Quel est le plus performant ?

J'ai lu ici que Salvatore Sanfilippo conseille Claude Sonnet 3.5 :

About "people still thinking LLMs are quite useless", I still believe that the problem is that most people are exposed to ChatGPT 4o that at this point for my use case (programming / design partner) is basically a useless toy. And I guess that in tech many folks try LLMs for the same use cases. Try Claude Sonnet 3.5 (not Haiku!) and tell me if, while still flawed, is not helpful.

Repository de ce projet :

- La branche

neovim-avante-pocdu repository https://github.com/stephane-klein/dotfiles

Ressources :

Site officiel : https://aider.chat

Aider lets you pair program with LLMs to start a new project or build on your existing codebase.

Notes de Simon Willison au sujet de Aider : https://simonwillison.net/search/?tag=aider

Voir aussi : aider-ce.

Dernière page.