Elasticsearch

Article Wikipedia : https://en.wikipedia.org/wiki/Elasticsearch

Documentation : https://www.elastic.co/docs

Voir aussi le fork : OpenSearch.

Journaux liées à cette note :

Publication du projet 33 - "POC serveur Git HTTP qui injecte du contenu dans OpenSearch"

Je viens de terminer le "Projet 33 - "POC serveur Git HTTP qui injecte du contenu dans OpenSearch"" en 25h.

Si j'inclus le travail préliminaire du Projet 32 - "POC serveur Git HTTP avec exécution de scripts au push", cela représente 34h au total.

Voici le repository avec le résultat final : https://github.com/stephane-klein/poc-content-repository-git-to-opensearch.

J'ai réussi à implémenter preque tous les éléments que j'avais prévu :

- Un serveur Git HTTP supportant les opérations push et pull

- Après chaque git push, injection automatique des données reçues vers une base de données OpenSearch

- Intégration d'un système de job queue minimaliste qui permet de traiter les tâches d'importation des données Git vers OpenSearch de manière asynchrone. Cela permet entre autres de rendre l'opération git push non bloquante.

- Le modèle de données doit permettre l'accès au contenu de plusieurs branches.

- Upload des fichiers binaires vers un serveur Minio tout concervant leurs metadata (chemin, branche, etc) dans OpenSearch.

- La suppression d'une branche ou d'un commit doit aussi supprimer les données présentes dans OpenSearch et Minio.

- Utilisation de la librairie nodegit.

Le seul élément que je n'ai pas testé est celui-ci :

- L'accès aux données via l'API de OpenSearch ne doit pas être perturbé pendant les phases d'importation de données depuis Git.

Je précise d'emblée que l'implémentation de la fonctionnalité d'exploration web du content repository manque actuellement d'élégance.

Les dossiers suivants contiennent une quantité importante de code dupliqué :

src/routes/[...pathname]/,src/routes/branches/[branch_name]/[...pathname]/- et

src/routes/r/[revision]/[...pathname]/

src/routes

├── branches

│ ├── [branch_name]

│ │ ├── history

│ │ │ ├── +page.server.js

│ │ │ └── +page.svelte

│ │ ├── +page.server.js

│ │ ├── +page.svelte

│ │ └── [...pathname]

│ │ ├── +page.server.js

│ │ └── +page.svelte

│ ├── +page.server.js

│ └── +page.svelte

├── +page.server.js

├── +page.svelte

├── [...pathname]

│ ├── +page.server.js

│ ├── +page.svelte

│ └── raw

│ └── +server.js

└── r

├── +page.server.js

└── [revision]

├── history

│ ├── +page.server.js

│ └── +page.svelte

├── +page.server.js

├── +page.svelte

└── [...pathname]

├── +page.server.js

├── +page.svelte

└── raw

Pour le moment, je n'ai pas encore trouvé comment éviter cette duplication de manière élégante.

J'ai pensé à 3 approches pour améliorer cette implémentation :

- Factoriser la logique de query des fichiers

+page.server.jsdans une fonction partagée. - Migrer complètement ces pages d'exploration vers

src/hooks.server.js(avec les Server hooks de SvelteKit ).

Comme cette partie n'était pas au cœur du projet, j'ai préféré ne pas y investir davantage de temps.

Dans ce projet, j'ai utilisé pour la première fois OpenSearch, le fork de Elasticsearch. J'ai dû faire quelques adaptations par rapport à Elasticsearch mais rien de vraiment complexe.

J'ai utilisé la librairie @opensearch-project/opensearch avec succès, bien aidé par Claude Sonnet 4 pour écrire mes query OpenSearch.

J'aimerais mieux maîtriser l'api de OpenSearch et Elasticsearch, mais je ne les utilise pas suffisamment.

Cette dépendance à un LLM pour écrire ces requêtes me contrarie, je me sens prolétaire et j'ai le sentiment de perdre l'habitude de l'effort. Je pense à cette recherche "Your Brain on ChatGPT: Accumulation of Cognitive Debt when Using an AI Assistant for Essay Writing Task" et cela me préoccupe.

J'ai développé un système de job queue minimaliste en NodeJS avec une persistance basée sur des fichiers json simples : src/lib/server/job-queue.js.

Ma recherche avec Claude Sonnet 4 n'a révélé aucune librairie minimaliste existante qui se contente de fichiers pour la persistance.

Cette implémentation me paraît suffisamment robuste pour répondre à l'objectif que je me suis fixé.

J'ai implémenté la fonction importRevision avec nodegit pour parcourir toutes les entrées d'une révision Git du repository et les importer dans OpenSearch.

Claude Sonnet 4 m'a encore été d'une grande aide, me permettant d'éviter de passer trop de temps dans la documentation d'API de NodeGit, qui reste assez minimaliste.

Mon expérience de 2015 avec git2go sur le projet CmsHub avait été nettement plus laborieuse, à l'époque pré-LLM. Cela dit, j'avais quand même réussi. 🙂

L'implémentation du endpoint /src/routes/post_recieve_hook_url/+server.js n'a pas été très difficile.

J'ai réussi à implémenter le support de git push --force sans trop de difficulté.

Qu'est-ce qui t'a amené à choisir OpenSearch pour ce projet, plutôt qu'un autre type de base de données ?

Suite à de multiples expérimentations durant l'été 2024 (voir 2024-08-17_1253 ou Projet 5), j'ai sélectionné Elasticsearch comme moteur de base de données pour sklein-pkm-engine.

La puissance du moteur de query d'Elasticsearch m'a vraiment séduit, comme on peut le voir dans cette implémentation. Ça me paraît beaucoup plus souple que ce que j'avais développé avec postgres-tags-model-poc.

J'ai donc décidé d'explorer les possibilités d'Elasticsearch ou de son fork OpenSearch comme moteur de base de données de content repository. J'ai décidé d'en faire mon option par défaut tant que je ne rencontre pas d'obstacle majeur ou de point bloquant.

La partie où j'ai le plus hésité concerne le choix du modèle de données OpenSearch pour stocker efficacement le versioning Git.

J'ai décidé d'utiliser deux indexes distincts : files et commits :

await client.indices.create({

index: "files",

body: {

mappings: {

properties: {

content: {

type: "text"

},

mimetype: {

type: 'keyword'

},

commits: {

type: 'object',

dynamic: 'true'

}

}

}

}

});

await client.indices.create({

index: "commits",

body: {

mappings: {

properties: {

index: {

type: 'integer'

},

time: {

type: 'date',

format: 'epoch_second'

},

message: {

type: "text"

},

parents: {

type: 'keyword'

},

entries: {

type: 'object',

dynamic: 'true',

},

branches: {

type: 'keyword'

}

}

}

}

});

Après import des données depuis le repository dummy-content-repository-solar-system, voici ce qu'on trouve dans files :

[

{

_index: 'files',

_id: '2f729046cb0f02820226c1183aa04ab20ceb857d',

_score: 1,

_source: {

commits: {

'4da69e469145fe5603e57b9e22889738d066a5e2': 'mars.md',

d9bffc3da0c91366dda54fefa01383b109554054: 'mars.md'

},

mimetype: 'text/markdown; charset=utf-8'

}

},

{

_index: 'files',

_id: '1be731144f49282c43b5e7827bef986a52723a71',

_score: 1,

_source: {

commits: {

'4da69e469145fe5603e57b9e22889738d066a5e2': 'venus.md',

d9bffc3da0c91366dda54fefa01383b109554054: 'venus.md'

},

mimetype: 'text/markdown; charset=utf-8'

}

},

{

_index: 'files',

_id: 'ccc921b7a66f18e98f4887189824eefe83c7e0b3',

_score: 1,

_source: {

commits: {

'4da69e469145fe5603e57b9e22889738d066a5e2': 'terre/index.md',

a9272695d179e70cca15e89f1632b8fb76112dca: 'terre/index.md',

d9bffc3da0c91366dda54fefa01383b109554054: 'terre/index.md'

},

mimetype: 'text/markdown; charset=utf-8'

}

},

{

_index: 'files',

_id: '153d9d6e9dfedb253c624c9f25fbdb7d8691a042',

_score: 1,

_source: {

commits: {

'4da69e469145fe5603e57b9e22889738d066a5e2': 'terre/lune.md',

a9272695d179e70cca15e89f1632b8fb76112dca: 'terre/lune.md',

d9bffc3da0c91366dda54fefa01383b109554054: 'terre/lune.md'

},

mimetype: 'text/markdown; charset=utf-8'

}

},

{

_index: 'files',

_id: '97ef5b8f52f85c595bf17fac6cbec856ce80bd4a',

_score: 1,

_source: {

commits: { '4da69e469145fe5603e57b9e22889738d066a5e2': 'terre/terre.jpg' },

mimetype: 'image/jpeg'

}

}

]

et voici un exemple de contenu de commits :

[

{

_index: 'commits',

_id: '7ce2ab6f8d29fec0348342d95bfe71899dcb44fa',

_score: 1,

_source: { index: 1, time: 1757420855, branches: [ 'main' ], parents: [] }

},

{

_index: 'commits',

_id: '4da69e469145fe5603e57b9e22889738d066a5e2',

_score: 1,

_source: {

entries: {

'venus.md': {

oid: '1be731144f49282c43b5e7827bef986a52723a71',

contentType: 'text/markdown; charset=utf-8'

},

'terre/lune.md': {

oid: '153d9d6e9dfedb253c624c9f25fbdb7d8691a042',

contentType: 'text/markdown; charset=utf-8'

},

'mars.md': {

oid: '2f729046cb0f02820226c1183aa04ab20ceb857d',

contentType: 'text/markdown; charset=utf-8'

},

'terre/terre.jpg': {

oid: '97ef5b8f52f85c595bf17fac6cbec856ce80bd4a',

contentType: 'image/jpeg'

},

'terre/index.md': {

oid: 'ccc921b7a66f18e98f4887189824eefe83c7e0b3',

contentType: 'text/markdown; charset=utf-8'

}

},

index: 4,

time: 1757429173,

branches: [ 'main' ],

parents: [ 'd9bffc3da0c91366dda54fefa01383b109554054' ]

}

},

{

_index: 'commits',

_id: 'd9bffc3da0c91366dda54fefa01383b109554054',

_score: 1,

_source: {

entries: {

'venus.md': {

oid: '1be731144f49282c43b5e7827bef986a52723a71',

contentType: 'text/markdown; charset=utf-8'

},

'terre/lune.md': {

oid: '153d9d6e9dfedb253c624c9f25fbdb7d8691a042',

contentType: 'text/markdown; charset=utf-8'

},

'mars.md': {

oid: '2f729046cb0f02820226c1183aa04ab20ceb857d',

contentType: 'text/markdown; charset=utf-8'

},

'terre/index.md': {

oid: 'ccc921b7a66f18e98f4887189824eefe83c7e0b3',

contentType: 'text/markdown; charset=utf-8'

}

},

index: 3,

time: 1757421171,

branches: [ 'main' ],

parents: [ 'a9272695d179e70cca15e89f1632b8fb76112dca' ]

}

},

{

_index: 'commits',

_id: 'a9272695d179e70cca15e89f1632b8fb76112dca',

_score: 1,

_source: {

entries: {

'terre/lune.md': {

oid: '153d9d6e9dfedb253c624c9f25fbdb7d8691a042',

contentType: 'text/markdown; charset=utf-8'

},

'terre/index.md': {

oid: 'ccc921b7a66f18e98f4887189824eefe83c7e0b3',

contentType: 'text/markdown; charset=utf-8'

}

},

index: 2,

time: 1757420956,

branches: [ 'main' ],

parents: [ '7ce2ab6f8d29fec0348342d95bfe71899dcb44fa' ]

}

}

]

Ensuite, je mise beaucoup sur la puissance du moteur de requête d'OpenSearch pour récupérer efficacement les données à afficher.

Voici l'exemple de src/routes/[...pathname]/+page.server.js qui permet d'afficher le contenu d'un fichier de la branche main.

Première requête :

const responseOid = await client().search({

index: 'commits',

body: {

query: {

bool: {

must: [

{

term: {

branches: 'main'

}

},

{

exists: {

field: `entries.${params.pathname}`

}

}

]

}

},

_source: [`entries.${params.pathname}`]

}

});

Seconde requête qui utilise la réponse de la première :

const responseFile = await client().get({

index: 'files',

id: responseOid.body.hits.hits[0]._source.entries[params.pathname].oid,

_source: ['content', 'mimetype']

});

Basé sur l'expérience de ce projet, je souhaite améliorer sklein-pkm-engine pour permettre la mise à jour de notes.sklein.xyz avec mes données locales uniquement via git push, sans avoir besoin d'installer quoi que ce soit sur ma workstation.

Je pense que cette implémentation sera bien plus simple que le Projet 33, car je ne prévois pas d'inclure le support dans un premier temps. Peut-être que je supporterai les branches dans un second temps.

Première description du gestionnaire de projet de mes rêves

Introduction

Cela fait depuis 2022 que je souhaite prototyper un outil de gestion de tâches (issues) avec certaines fonctionnalités que je n'ai trouvées dans aucun outils Open source ou closed-source.

En novembre 2022, j'ai commencé le tout début d'un modèle de données PostgreSQL, mais je n'ai pas continué.

Je souhaite, dans cette note, présenter mon idée de prototype, présenter les fonctionnalités que j'aimerais implémenter.

Nom du projet : Projet 24 - Prototyper le gestionnaire de projet de mes rêves

Ces idées de fonctionnalité sont tirées de besoin personnel que j'ai rencontré depuis 2018, dans mes différents projets professionnel en équipe.

Pour réduire mon temps de rédaction de cette note et la publier au plus tôt, je ne souhaite pas détailler ici l'origine de ces besoins.

Je souhaite juste décrire quelques fonctionnalités que je souhaite et quelque détail technique sans expliquer l'origine de mon besoin.

Sources d'inspiration

Mes principales sources d'inspiration :

- Certaines fonctionnalités issues et projects de GitHub et ses dernières améliorations.

- Certaines fonctionnalités Plan and track work de GitLab.

- Certaines fonctionnalités de Basecamp, par exemple, j'adore les Hill Charts (https://basecamp.com/hill-charts).

- Certaines fonctionnalités de Linear.

- Certaines fonctionnalités de OpenProject

Je me projette d'utiliser Projet 24 dans les framework de gestion de projets suivants :

Ainsi qu'avec la technologie sociale Sociocratie 3.0.

Liste de fonctionnalités en vrac

- Permettre d'importer / exporter une ou plusieurs issues dans un format de fichier YAML.

- Permettre d'importer / exporter ces fichiers via Git.

- Permettre l'utilisation de branche : création, suppression, merge de branches.

- Permettre la gestion des branches via l'interface web.

- Visualisation web des diff entre deux branches.

- Permettre de commit ou créer des snapshots d'une branche.

- Permettre d'attribuer à une issue une estimation basse et haute de temps d'implémentation.

- Permettre d'activer un Hill Charts sur toute issue.

- Permettre d'indiquer un niveau d'approximation d'une issue

- Permettre aux lectures d'une issue d'indiquer leur niveau de compréhension de l'issue

- Permettre de configurer la taille maximum en mots d'une issue. Pour forcer un certain niveau de synthèse.

- Permettre de calculer le poids d'une issue en faisant la somme basse et haute de toutes ses dépendances.

- Système inspiré de Tinder pour prioriser les issues. L'application présente deux issues choisies selon un algorithme Elo et invite l'utilisateur à désigner celle qu'il considère comme prioritaire.

- Implémenter un système de tags d'issues personnalisés où chaque utilisateur peut créer ses propres étiquettes. La visibilité de ces tags serait configurable : mode privé pour un usage personnel ou mode partagé pour les rendre disponibles aux autres utilisateurs.

- Permettre de créer des portfolios d'issue par utilisateurs.

- Pas de séparation des entités Epic (gestion de projet logiciel) / Issue contrairement à ce que fait GitLab.

- Permettre d'utilisation d'une extension Browser pour enrichir les pages GitHub, GitLab, Linear ou Forgejo avec les fonctionnalités de Projet 24.

- Permettre au Projet 24 d'améliorer une instance privé Forgejo avec un wrapper HTTP.

- Système de dashboard pratiquement identique à GitHub projects.

- Système de commentaire comme GitHub, mais avec un système de thread.

- Support de wikilink et alias au niveau de toutes les ressources texte.

- Support d'une fonctionnalité de publication de notes éphémères attachées à chaque utilisateur.

- Permettre la création d'issues ou de notes "flottantes". Une issue "flottante" n'appartient à aucune ressource spécifique — elle n'est rattachée ni à un projet, ni à un groupe. Cette fonctionnalité me semble essentielle et je compte la détailler dans une note dédiée prochainement.

- Proposer une extension Browser qui détecte automatiquement les issues liées à l'URL de la page actuelle. Cela permettrait d'accéder rapidement aux issues ou notes "flottantes" selon le contexte de navigation.

- Très bon support Markdown, contrairement aux implémentations de Slack, Notion ou Linear. Il devrait être possible de basculer entre le mode d'édition riche et le mode markdown. Le contenu copié doit générer du markdown valide dans le presse-papier.

- Respect strict des conventions Web : permettre l'ouverture de toutes les pages dans un nouvel onglet, etc.

- Mettre l'accent sur la performance de rendu des pages. Implémenter en priorité un système de métriques pour mesurer les temps de rendu.

- Proposer un système de génération de titre d'issue et de tag basé sur un LLM.

- Mettre en place un système qui utilise un LLM pour proposer automatiquement des titres d'issues et des tags.

- Alimenter une base de données vectorielle avec les descriptions d'issues et leurs commentaires pour activer la recherche sémantique.

Expérience utilisateur

Comme SilverBullet.mb, un outil fait dans un premier temps pour les hackers.

Détails techniques

- Stockage dans Elasticsearch pour faciliter les recherches par tags et plain text.

- Utilisation de nanoid de 5 caractères pour identifier les issues.

- Utilisation de Git hook pre-receive côté serveur pour importer des données (issues, notes, etc)

Journal du samedi 21 décembre 2024 à 16:10

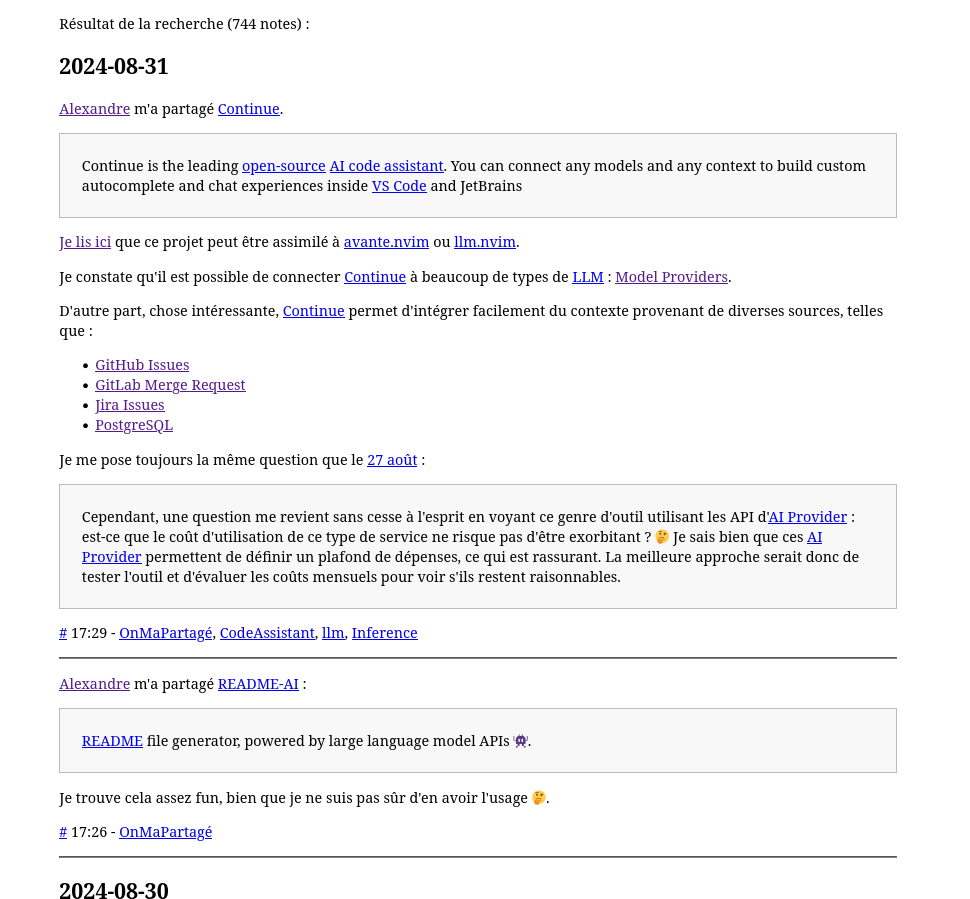

Je viens d'améliorer l'implémentation du moteur de recherche de mon sklein-pkm-engine.

Voici un screencast de présentation du résultat :

Le commit de changement : https://github.com/stephane-klein/sklein-pkm-engine/commit/71210703fe626bd455b2ec7774167d9a637e4972

Je suis passé de :

query_string: {

query: queryString,

default_field: "content_html"

}

à ceci :

multi_match: {

query: queryString,

fields: ["title^2", "content_html"],

fuzziness: "AUTO",

type: "best_fields"

}

Les fonctionnalités de recherche d'Elasticsearch sont nombreuses. Pour les parcourir, je conseille ce point d'entrée de la documentation Search in Depth.

Même après avoir fini mon implémentation de la fonction recherche, je dois avouer que je tâtonne sur le sujet. Je suis loin de maitriser le sujet.

Au départ, après lecture de ce paragraphe :

If you don’t need to support a query syntax, consider using the

matchquery. If you need the features of a query syntax, use thesimple_query_stringquery, which is less strict.

J'ai fait un refactoring de query_string vers simple_query_string (lien vers la documentation).

Mon objectif était d'arriver à implémenter la fonctionnalité Query-Time Search-as-You-Type avec de la recherche floue (fuzzy).

J'ai commencé par essayer la syntax foobar~* mais j'ai appris qu'il n'était pas possible d'utiliser ~ (fuzzy) en couplé avec * 😔 (documentation vers la syntax). Sans doute pour de bonnes raisons, liées à des problèmes de performance.

J'ai ensuite découpé ma requête en 3 conditions :

baseQuery.body.query.bool.must.push({

bool: {

should: [

{

simple_query_string: {

query: queryString,

fields: ["content_html"],

boost: 3

}

},

{

simple_query_string: {

query: queryString.split(' ').map(word => (word.length >= 3) ? `${word}*` : undefined).join(' ').trim(),

fields: ["content_html"],

boost: 1

}

},

{

simple_query_string: {

query: queryString.split(' ').map(

word => {

if (word.length >= 5) { return `${word}~2`; }

else if (word.length >= 3) { return `${word}~1`; }

else return undefined;

}

).join(' ').trim(),

fields: ["content_html"],

boost: 1

}

}

],

minimum_should_match: 1

}

}

Cette implémentation fonctionne, mais je rencontrais des problèmes de performance aléatoires que je n'ai pas pris le temps d'essayer de comprendre la cause.

À force de tâtonnement, j'ai fini par choisir la solution basée sur multi_match (documentation de référence) :

multi_match: {

query: queryString,

fields: ["title^2", "content_html"],

fuzziness: "AUTO",

type: "best_fields"

}

Documentation de référence du paramètre fuzziness : Fuzzy query.

Documentation de la valeur AUTO : Common options - Fuzziness

Malheureusement, ici aussi, je ne peux pas utiliser fuzziness avec phrase_prefix :

The fuzziness parameter cannot be used with the phrase or phrase_prefix type.

En finissant cette note, je viens de découvrir cet exemple dans la documentation.

J'ai l'impression de comprendre qu'en utilisant le tokenizer ngram je pourrais faire des Fuzzy Search sans utiliser l'option fuzziness 🤔.

J'ai commencé l'implémentation dans la branche ngram-tokenizer mais je m'arrête là pour aujourd'hui. En tout, ce weekend, j'ai passé 4h30 sur ce sujet 😮.

J'espère tester cette implémentation d'ici à quelques jours.

Je souhaite aussi essayer prochainement de migrer de Elasticsearch vers OpenSearch.

Journal du lundi 28 octobre 2024 à 14:56

Je rassemble ici quelques notes au sujet de projet Hasura.

À l'origine, Hasura était uniquement un moteur GraphQL open-source qui se branchait directement sur une base de données PostgreSQL. Le projet a commencé en 2018, bien que le site web soit plus ancien — 2015.

D'après le dépôt GitHub, les premiers développeurs d'Hasura sont Shahidh K Muhammed, Vamshi Surabhi, Aravind Shankar et Rakesh Emmadi, tous basés à Bangalore, en Inde.

En 2019, dans un cadre professionnel, j'ai choisi d'utiliser un autre moteur GraphQL : PostGraphile.

Début 2020, j'avais également identifié Hasura et Supabase comme alternatives.

J'avais choisi d'utiliser PostGraphile pour plusieurs raisons :

- Supabase était encore un jeune projet, lancé en octobre 2019.

- Hasura était codé en Haskell, un langage que je ne maîtrise pas. En revanche, PostGraphile, développé en JavaScript, m'inspirait plus confiance, car je savais que j'avais les compétences nécessaires si je devais intervenir sur son code source, par exemple, pour corriger un bug.

- D'autre part, PostGraphile n'était pas financé par des Venture capital, ce qui m'inspirait bien plus confiance sur son avenir que Supabase et Hasura.

- J'apprécie énormément la façon de travailler de Benjie. J'apprécie sa manière d'organiser ses projets, ses documentations et ses choix techniques. Je pense que notre doctrine est assez similaire.

Quatre plus tard, je constate que PostGraphile a choisi de rester concentré sur un seul objectif : être un moteur GraphQL, tandis que Supabase et Hasura, bénéficiant d'un financement par des Venture capital, ont diversifié leurs offres.

Alors que PostGraphile se limite au support de PostgreSQL, Hasura peut se connecter à Mysql, MongoDB, Clickhouse, Elasticsearch…

Et d'après la documentation, Hasura permet d'exposer, en plus d'une API GraphQL, une API REST (RESTified Endpoints).

Journal du samedi 05 octobre 2024 à 11:38

Dans ce thread Reddit, #JaiDécouvert :

Cloud-native search engine for observability.. An open-source alternative to Datadog, Elasticsearch, Loki, and Tempo.

openITCOCKPIT is an Open Source system monitoring tool built for different monitoring engines like Nagios, Naemon and Prometheus.

🚀 10x easier, 🚀 140x lower storage cost, 🚀 high performance, 🚀 petabyte scale - Elasticsearch / Splunk / Datadog alternative for 🚀 (logs, metrics, traces, RUM, Error tracking, Session replay).

Journal du mercredi 02 octobre 2024 à 18:07

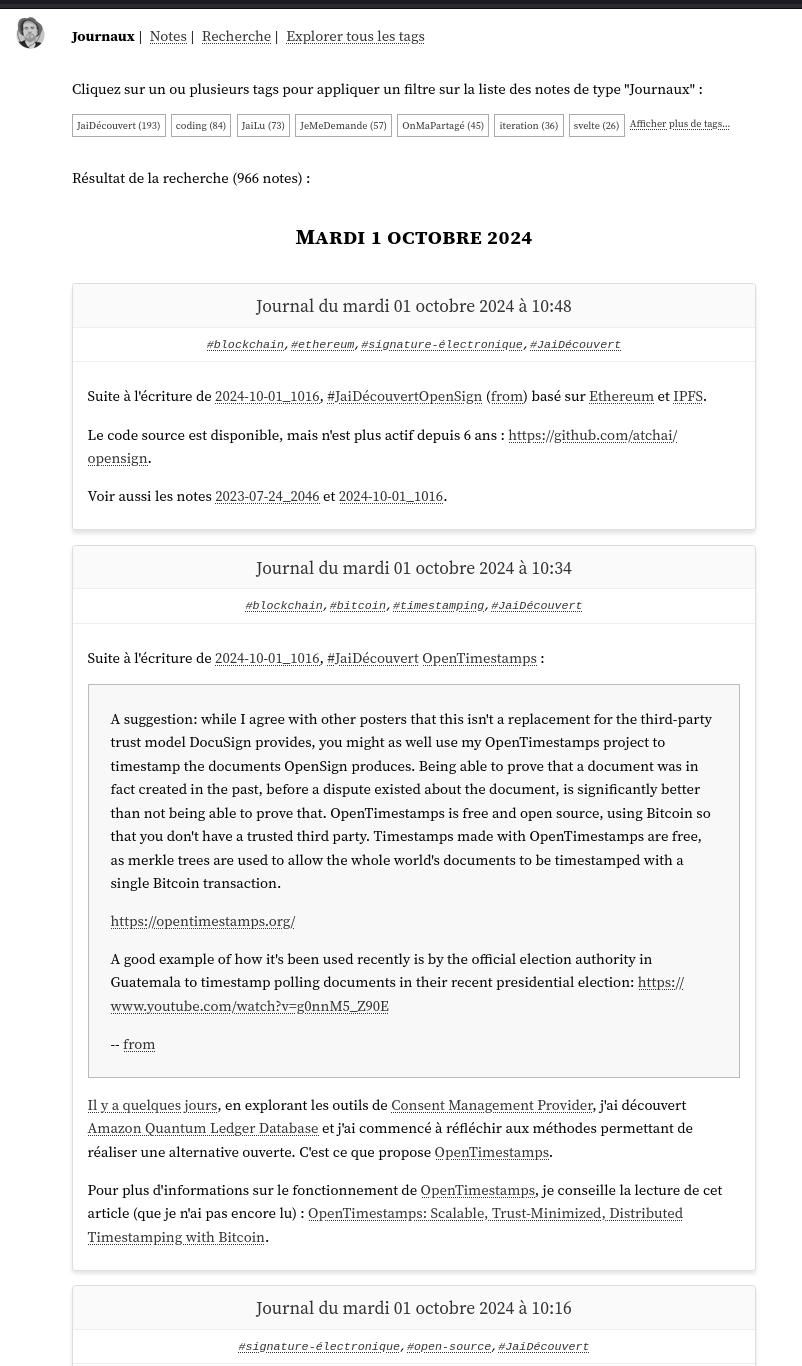

Nouvelle #iteration du Projet 11 - "Première version d'un moteur web PKM".

J'ai traité les tâches décrites dans ma dernière note.

- Comme me l'a signalé à plusieurs reprises Alexandre, je dois améliorer le rendu responsive sur smartphone. Jusqu'à présent, je n'ai pas encore consacré de temps à ce sujet.

- Je dois améliorer le script d'import des données dans Elasticsearch. Pour le moment, ici, je commence par supprimer toutes les données avant d'effectuer l'importation des données.

Problème : les pages ne sont plus accessibles pendant l'exécution de ce script.

J'ai enfin publié sklein-pkm-engine sur https://notes.sklein.xyz.

En mars 2024, j'écrivais :

Pour le moment, j'utilise Obsidian Quartz pour déployer https://notes.sklein.xyz.

Est-ce que j'en suis satisfait ? Pour le moment, la réponse est non, parce que je ne le maitrise pas assez.

J'ai une grande envie d'implémenter une version personnelle basée sur SvelteKit et Apache Age, mais j'essaie de ne pas tomber dans ce Yak!.

Début mai 2024, je suis tombé dans ce Yak!, j'y ai consacré 93 heures en tout, soit l'équivalent d'environ 15 jours de travail étalés sur 8 semaines.

J'ai enfin supprimé Obsidian Quartz

J'ai changé plusieurs fois de direction :

- j'ai exploré une implémentation basée sur Apache Age,

- ensuite pg_search,

- ensuite Typesense

- et pour finir, j'ai opté pour une implémentation basée sur Elasticsearch (voir détail dans Projet 13).

Je viens d'essayer de réaliser un screencast de présentation de la version actuelle de sklein-pkm-engine, mais le résultat de mon discours était vraiment trop déstructuré pour être publié. J'essaierai de publier un screencast prochainement.

Je viens de tenter de réaliser un screencast pour présenter la version actuelle de sklein-pkm-engine, mais mon discours était trop désorganisé pour être publié. Je souhaite enregistrer une nouvelle version prochainement.

Prochains objectifs concernant le projet sklein-pkm-engine :

- Traiter les dernières tâches que j'avais listées dans Projet 11 - "Première version d'un moteur web PKM" ;

- Dresser une liste des corrections de bug et des améliorations que je souhaite apporter à notes.sklein.xyz.

Journal du mardi 01 octobre 2024 à 11:55

Nouvelle #iteration du Projet 11 - "Première version d'un moteur web PKM".

Dans ma dernière itération du 31 août 2024, j'écrivais ceci :

Voici quelque erreur d'User Interface que je souhaite corriger.

Sur ce screenshot, les notes actuellement séparé par des

<hr />ne sont pas facilement identifiable.

Depuis, j'ai travaillé dans la branche experimentation-ui et pour le moment, j'ai le résultat suivant :

Je pense que les délimitations des notes sont maintenant mieux identifiables.

Problème User Interface que j'ai identifié : je pense que la présence d'un lien sur le titre de la note n'est pas facilement "découvrable".

Mon objectif est toujours le suivant :

Maintenant mon objectif est d'apporter le minimum de petite amélioration me permettant de remplacer l'instance notes.sklein.xyz propulsé actuellement par Obsidian Quartz par une version propulsé par

sklein-pkm-engine.-- from

Voici la liste des choses que je dois implémenter pour atteindre cet objectif.

- Comme me l'a signalé à plusieurs reprises Alexandre, je dois améliorer le rendu responsive sur smartphone. Jusqu'à présent, je n'ai pas encore consacré de temps à ce sujet.

- Je dois améliorer le script d'import des données dans Elasticsearch. Pour le moment, ici, je commence par supprimer toutes les données avant d'effectuer l'importation des données.

Problème : les pages ne sont plus accessibles pendant l'exécution de ce script.

Je pense qu'après avoir traité ces deux tâches, je pourrais abandonner Obsidian Quartz et seulement ensuite implémenter toutes les idées pour améliorer mon Personal knowledge management "viewer".

Journal du jeudi 29 août 2024 à 13:23

Voici les nouveautés depuis ma dernière itération du Projet 11 - "Première version d'un moteur web PKM".

Ce commit contient le résultat du travail du Projet 13, c'est-à-dire le refactoring de PostgreSQL vers Elasticsearch ainsi que la page /src/routes/search qui permet à la fois d'effectuer une recherche sur le contenu des notes et un filtrage de type and sur les tags.

Une démo est visible ici https://notes.develop.sklein.xyz/

Ma Developer eXperience avec Elasticsearch est excellente. J'ai trouvé toutes les fonctionnalités dont j'avais besoin.

Je pense que mon utilisation des Fleeting Note n'est pas la bonne. Je pense que les notes que je qualifie de Fleeting Note sont en réalité des Diary notes ou Journal notes.

J'ai donc décidé de :

- [x] Renommer partout

fleeting_noteenjournal_notes

Après implémentation, j'ai réalisé que j'ai fait l'erreur de mélanger l'implémentation de le page qui affiche la liste des notes antéchronologiques et la page de recherche.

Pour être efficace, le résultat de la page recherche doit être affiché en fonction du scoring de la recherche, alors que les pages listes de notes par date de publication.

J'ai donc décidé de :

- [x] Implémenter une page

/diaries/(pour la cohérence des path en anglais, je préfère "diaries" à "journaux") qui affiche une liste de notes de type Diary notes ;- [x] Cette page doit permettre un filtrage par tags

- [x] Implémenter une page

/notes/qui affiche une liste des notes qui ne sont pas de type Diary notes, comme des Evergreen Note, Hub note…- [x] Contrairement à la page liste des Diary notes, cette page de liste ne doit pas afficher le contenu des notes, mais seulement le titre des notes ;

- [x] Je propose de classer ces titres de notes par ordre alphabétique ;

- [x] Je propose aussi de séparer ces notes par lettre,

A,B… c'est-à-dire un index alphabétique. - [x] Cette page doit permettre un filtrage par tags

- [x] Refactoring la page

/search/pour ordonner le résultat de la recherche par scoring.- [x] Cette page doit afficher le contenu des notes avec highligthing ;

- [x] Cette page doit permettre un filtrage sur les types de notes, pour le moment Diary notes et Evergreen Note.

- [x] Cette page doit permettre un filtrage par tags

Au moment où j'écris ces lignes, je ne sais pas encore comment je vais gérer les opérateurs or, (.

Pour le moment, le filtrage multi tags est effectué avec des and.

Journal du dimanche 25 août 2024 à 11:00

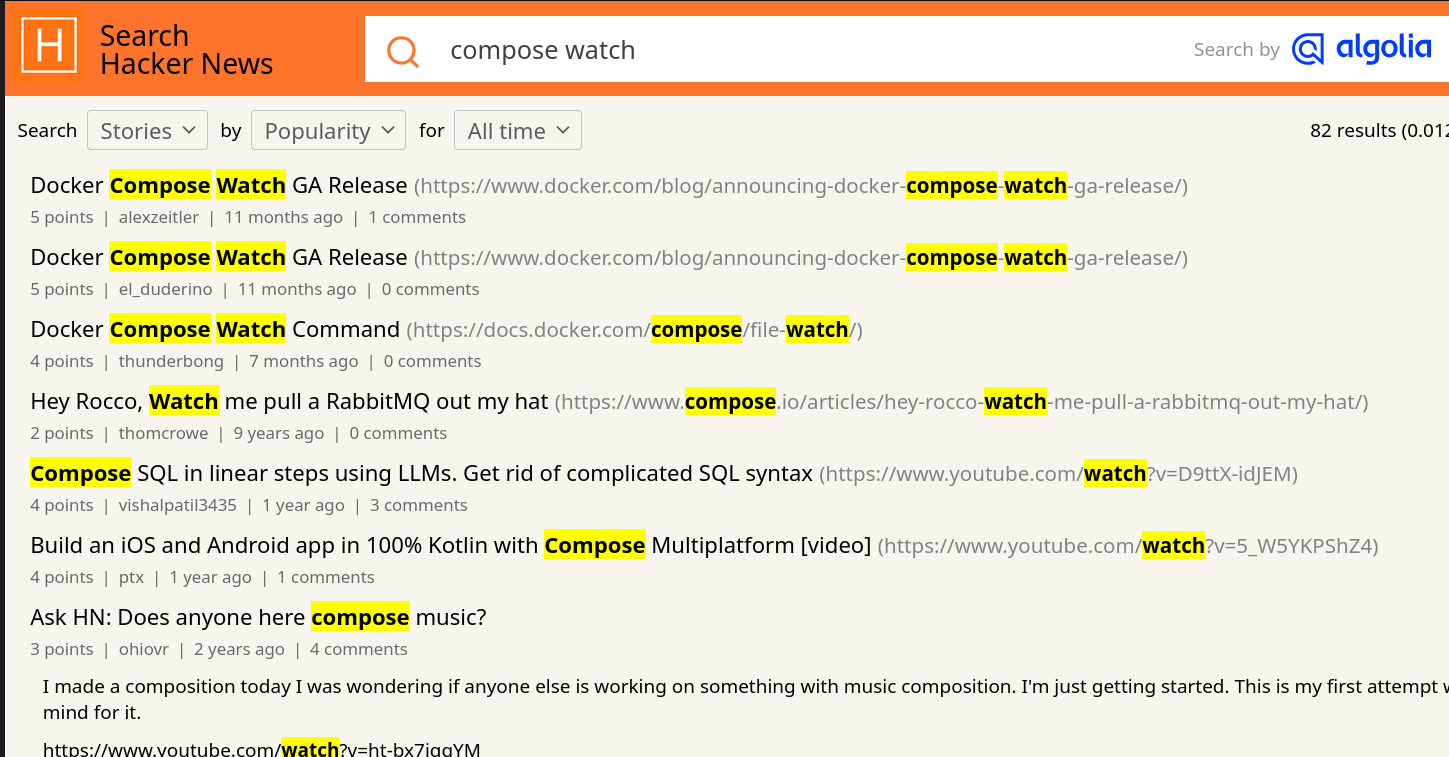

Alexandre m'a fait découvrir la fonctionnalité Compose Watch ajoutée en septembre 2023 dans la version 2.22.0 de docker compose.

Compose supports sharing a host directory inside service containers. Watch mode does not replace this functionality but exists as a companion specifically suited to developing in containers.

More importantly, watch allows for greater granularity than is practical with a bind mount. Watch rules let you ignore specific files or entire directories within the watched tree.

For example, in a JavaScript project, ignoring the node_modules/ directory has two benefits:

Performance. File trees with many small files can cause high I/O load in some configurations

Multi-platform. Compiled artifacts cannot be shared if the host OS or architecture is different to the container

-- from

Je suis très heureux de l'introduction de cette fonctionnalité, même si je n'ai pas encore eu l'occasion de la tester. Bien que je trouve qu'elle arrive un peu tardivement 😉.

Je suis surpris d'observer que cette fonction a généré très peu de réaction sur Hacker News 🤔.

Je n'ai rien trouvé non plus sur Reddit, ni sur Lobster 🤔.

Sans doute pour cela que je n'ai pas vu la sortie de cette fonctionnalité.

Je pense avoir retrouvé la première Pull Request de la fonctionnalité compose watch : [ENV-44] introduce experimental watch command (skeletton) #10163.

Je constate que compose watch est basé sur fsnotify.

Je constate ici qu'un système de "debounce" est implémenté.

Je pense que c'est cette fonction qui effectue la copie des fichiers, mais je n'en suis pas certain et je ai mal compris son fonctionnement.

Entre 2015 et 2019, j'ai rencontré de nombreux problèmes de performance liés aux volumes de type "bind" sous MacOS (et probablement aussi sous MS Windows) :

volumes:

- ./src/:/src/

Les performances étaient désastreuses pour les projets Javascript avec leurs node_modules volumineux.

Exécuter des commandes telles que npm install ou npm run build prenait parfois 10 à 50 fois plus de temps que sur un système natif ! Je précise que ce problème de performance était inexistant sous GNU Linux.

Pour résoudre ce problème pour les utilisateurs de MacOS, j'ai exploré plusieurs stratégies de development environment, comme l'utilisation de Vagrant avec différentes méthodes de montage, dont certaines reposaient sur une approche similaire à celle de Compose Watch, c'est-à-dire la surveillance des fichiers (fsnotify…) et leur copie.

N'ayant trouvé aucune solution pleinement satisfaisante, j'ai finalement adopté la stratégie Asdf, puis Mise, qui me convient parfaitement aujourd'hui.

Cela signifie que, dans mes environnements de développement, je n'utilise plus Docker pour les services sur lesquels je développe, qu'ils soient implémentés en JavaScript, Python ou Golang...

En revanche, j'utilise toujours Docker pour les services complémentaires tels que PostgreSQL, Redis, Elasticsearch, etc.

Est-ce que la fonctionnalité Compose Watch remettra en question ma stratégie basée sur Mise ? Pour l'instant, je ne le pense pas, car je ne rencontre aucun inconvénient majeur avec ma configuration actuelle et l'expérience développeur (DX) est excellente.

Journal du samedi 17 août 2024 à 15:21

Je repository GitHub officiel des images Docker de Elasticsearch se trouve ici : https://github.com/elastic/elasticsearch/tree/main/distribution/docker.